搜索到

11

篇与

的结果

-

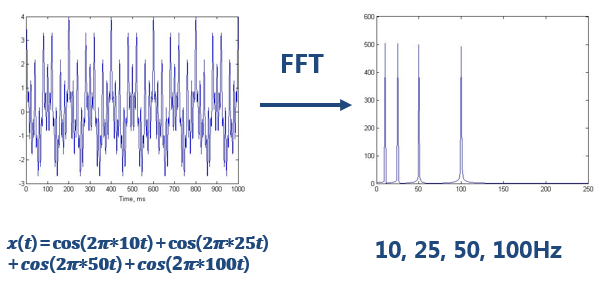

形象易懂讲解算法I——小波变换 https://zhuanlan.zhihu.com/p/22450818从傅里叶变换到小波变换,并不是一个完全抽象的东西,可以讲得很形象。小波变换有着明确的物理意义,如果我们从它的提出时所面对的问题看起,可以整理出非常清晰的思路。下面我就按照傅里叶-->短时傅里叶变换-->小波变换的顺序,讲一下为什么会出现小波这个东西、小波究竟是怎样的思路。(反正题主要求的是通俗形象,没说简短,希望不会太长不看。。)一、傅里叶变换关于傅里叶变换的基本概念在此我就不再赘述了,默认大家现在正处在理解了傅里叶但还没理解小波的道路上。(在第三节小波变换的地方我会再形象地讲一下傅里叶变换)下面我们主要讲傅里叶变换的不足。即我们知道傅里叶变化可以分析信号的频谱,那么为什么还要提出小波变换?答案在于,“对非平稳过程,傅里叶变换有局限性”。看如下一个简单的信号:做完FFT(快速傅里叶变换)后,可以在频谱上看到清晰的四条线,信号包含四个频率成分。一切没有问题。但是,如果是频率随着时间变化的非平稳信号呢?如上图,最上边的是频率始终不变的平稳信号。而下边两个则是频率随着时间改变的非平稳信号,它们同样包含和最上信号相同频率的四个成分。做FFT后,我们发现这三个时域上有巨大差异的信号,频谱(幅值谱)却非常一致。尤其是下边两个非平稳信号,我们从频谱上无法区分它们,因为它们包含的四个频率的信号的成分确实是一样的,只是出现的先后顺序不同。可见,傅里叶变换处理非平稳信号有天生缺陷。它只能获取一段信号总体上包含哪些频率的成分,但是对各成分出现的时刻并无所知。因此时域相差很大的两个信号,可能频谱图一样。然而平稳信号大多是人为制造出来的,自然界的大量信号几乎都是非平稳的,所以在比如生物医学信号分析等领域的论文中,基本看不到单纯傅里叶变换这样naive的方法。上图所示的是一个正常人的事件相关电位。对于这样的非平稳信号,只知道包含哪些频率成分是不够的,我们还想知道各个成分出现的时间。知道信号频率随时间变化的情况,各个时刻的瞬时频率及其幅值——这也就是时频分析。二、短时傅里叶变换(Short-time Fourier Transform, STFT)一个简单可行的方法就是——加窗。我又要套用方沁园同学的描述了,“把整个时域过程分解成无数个等长的小过程,每个小过程近似平稳,再傅里叶变换,就知道在哪个时间点上出现了什么频率了。”这就是短时傅里叶变换。看图:时域上分成一段一段做FFT,不就知道频率成分随着时间的变化情况了吗!用这样的方法,可以得到一个信号的时频图了:——此图像来源于“THE WAVELET TUTORIAL”图上既能看到10Hz, 25 Hz, 50 Hz, 100 Hz四个频域成分,还能看到出现的时间。两排峰是对称的,所以大家只用看一排就行了。是不是棒棒的?时频分析结果到手。但是STFT依然有缺陷。使用STFT存在一个问题,我们应该用多宽的窗函数?窗太宽太窄都有问题:窗太窄,窗内的信号太短,会导致频率分析不够精准,频率分辨率差。窗太宽,时域上又不够精细,时间分辨率低。(这里插一句,这个道理可以用海森堡不确定性原理来解释。类似于我们不能同时获取一个粒子的动量和位置,我们也不能同时获取信号绝对精准的时刻和频率。这也是一对不可兼得的矛盾体。我们不知道在某个瞬间哪个频率分量存在,我们知道的只能是在一个时间段内某个频带的分量存在。 所以绝对意义的瞬时频率是不存在的。)看看实例效果吧:——此图像来源于“THE WAVELET TUTORIAL”上图对同一个信号(4个频率成分)采用不同宽度的窗做STFT,结果如右图。用窄窗,时频图在时间轴上分辨率很高,几个峰基本成矩形,而用宽窗则变成了绵延的矮山。但是频率轴上,窄窗明显不如下边两个宽窗精确。所以窄窗口时间分辨率高、频率分辨率低,宽窗口时间分辨率低、频率分辨率高。对于时变的非稳态信号,高频适合小窗口,低频适合大窗口。然而STFT的窗口是固定的,在一次STFT中宽度不会变化,所以STFT还是无法满足非稳态信号变化的频率的需求。三、小波变换那么你可能会想到,让窗口大小变起来,多做几次STFT不就可以了吗?!没错,小波变换就有着这样的思路。但事实上小波并不是这么做的(关于这一点,方沁园同学的表述“小波变换就是根据算法,加不等长的窗,对每一小部分进行傅里叶变换”就不准确了。小波变换并没有采用窗的思想,更没有做傅里叶变换。)至于为什么不采用可变窗的STFT呢,我认为是因为这样做冗余会太严重,STFT做不到正交化,这也是它的一大缺陷。于是小波变换的出发点和STFT还是不同的。STFT是给信号加窗,分段做FFT;而小波直接把傅里叶变换的基给换了——将无限长的三角函数基换成了有限长的会衰减的小波基。这样不仅能够获取频率,还可以定位到时间了~【解释】来我们再回顾一下傅里叶变换吧,没弄清傅里叶变换为什么能得到信号各个频率成分的同学也可以再借我的图理解一下。傅里叶变换把无限长的三角函数作为基函数:这个基函数会伸缩、会平移(其实本质并非平移,而是两个正交基的分解)。缩得窄,对应高频;伸得宽,对应低频。然后这个基函数不断和信号做相乘。某一个尺度(宽窄)下乘出来的结果,就可以理解成信号所包含的当前尺度对应频率成分有多少。于是,基函数会在某些尺度下,与信号相乘得到一个很大的值,因为此时二者有一种重合关系。那么我们就知道信号包含该频率的成分的多少。仔细体会可以发现,这一步其实是在计算信号和三角函数的相关性。看,这两种尺度能乘出一个大的值(相关度高),所以信号包含较多的这两个频率成分,在频谱上这两个频率会出现两个峰。以上,就是粗浅意义上傅里叶变换的原理。如前边所说,小波做的改变就在于,将无限长的三角函数基换成了有限长的会衰减的小波基。这就是为什么它叫“小波”,因为是很小的一个波嘛~从公式可以看出,不同于傅里叶变换,变量只有频率ω,小波变换有两个变量:尺度a(scale)和平移量 τ(translation)。尺度a控制小波函数的伸缩,平移量 τ控制小波函数的平移。尺度就对应于频率(反比),平移量 τ就对应于时间。当伸缩、平移到这么一种重合情况时,也会相乘得到一个大的值。这时候和傅里叶变换不同的是,这不仅可以知道信号有这样频率的成分,而且知道它在时域上存在的具体位置。而当我们在每个尺度下都平移着和信号乘过一遍后,我们就知道信号在每个位置都包含哪些频率成分。看到了吗?有了小波,我们从此再也不害怕非稳定信号啦!从此可以做时频分析啦!做傅里叶变换只能得到一个频谱,做小波变换却可以得到一个时频谱!↑:时域信号↑:傅里叶变换结果——此图像来源于“THE WAVELET TUTORIAL”↑:小波变换结果小波还有一些好处,比如,我们知道对于突变信号,傅里叶变换存在吉布斯效应,我们用无限长的三角函数怎么也拟合不好突变信号:然而衰减的小波就不一样了:以上,就是小波的意义。以上只是用形象地给大家展示了一下小波的思想,希望能对大家的入门带来一些帮助。毕竟如果对小波一无所知,直接去看那些堆砌公式、照搬论文语言的教材,一定会痛苦不堪。在这里推荐几篇入门读物,都是以感性介绍为主,易懂但并不深入,对大家初步理解小波会很有帮助。文中有的思路和图也选自于其中:THE WAVELET TUTORIAL (强烈推荐,点击链接:Ihttp://users.rowan.edu/~polikar/WTtutorial.html)WAVELETS:SEEING THE FOREST AND THE TREESA Really Friendly Guide to WaveletsConceptual wavelets但是真正理解透小波变换,这些还差得很远。比如你至少还要知道有一个“尺度函数”的存在,它是构造“小波函数”的关键,并且是它和小波函数一起才构成了小波多分辨率分析,理解了它才有可能利用小波做一些数字信号处理;你还要理解离散小波变换、正交小波变换、二维小波变换、小波包……这些内容国内教材上讲得也很糟糕,大家就一点一点啃吧~一些问题的回答:关于海森堡不确定性原理不确定性原理,或者叫测不准原理,最早出自量子力学,意为在微观世界,粒子的位置与动量不可同时被确定。但是这个原理并不局限于量子力学,有很多物理量都有这样的特征,比如能量和时间、角动量和角度。体现在信号领域就是时域和频域。不过更准确一点的表述应该是:一个信号不能在时空域和频域上同时过于集中;一个函数时域越“窄”,它经傅里叶变换的频域后就越“宽”。如果有兴趣深入研究一下的话,这个原理其实非常耐人寻味。信号处理中的一些新理论在根本上也和它有所相连,比如压缩感知。如果你剥开它复杂的数学描述,最后会发现它在本质上能实现其实和不确定性原理密切相关。而且大家不觉得这样一些矛盾的东西在哲学意义上也很奇妙吗?关于正交化什么是正交化?为什么说小波能实现正交化是优势?简单说,如果采用正交基,变换域系数会没有冗余信息,变换前后的信号能量相等,等于是用最少的数据表达最大的信息量,利于数值压缩等领域。JPEG2000压缩就是用正交小波变换。比如典型的正交基:二维笛卡尔坐标系的(1,0)、(0,1),用它们表达一个信号显然非常高效,计算简单。而如果用三个互成120°的向量表达,则会有信息冗余,有重复表达。但是并不意味着正交一定优于不正交。比如如果是做图像增强,有时候反而希望能有一些冗余信息,更利于对噪声的抑制和对某些特征的增强。关于瞬时频率 原问题:图中时刻点对应一频率值,一个时刻点只有一个信号值,又怎么能得到他的频率呢? 很好的问题。如文中所说,绝对意义的瞬时频率其实是不存在的。单看一个时刻点的一个信号值,当然得不到它的频率。我们只不过是用很短的一段信号的频率作为该时刻的频率,所以我们得到的只是时间分辨率有限的近似分析结果。这一想法在STFT上体现得很明显。小波用衰减的基函数去测定信号的瞬时频率,思想也类似。(不过到了Hilbert变换,思路就不一样了,以后有机会细讲)关于小波变换的不足这要看和谁比了。A.作为图像处理方法,和多尺度几何分析方法(超小波)比:对于图像这种二维信号的话,二维小波变换只能沿2个方向进行,对图像中点的信息表达还可以,但是对线就比较差。而图像中最重要的信息恰是那些边缘线,这时候ridgelet(脊波), curvelet(曲波)等多尺度几何分析方法就更有优势了。B. 作为时频分析方法,和希尔伯特-黄变换(HHT)比:相比于HHT等时频分析方法,小波依然没脱离海森堡测不准原理的束缚,某种尺度下,不能在时间和频率上同时具有很高的精度;以及小波是非适应性的,基函数选定了就不改了。关于文中表述的严谨性评论中有不少朋友提到,我的一些表述不够精准。这是肯定的,并且我也是知道的。比如傅里叶变换的理解部分,我所说的那种“乘出一个大的值”的表述肯定是不够严谨的。具体我也在评论的回答中做了解释。我想说的是通俗易懂和精确严谨实在难以兼得,如果要追求严谨,最好的就是教科书上的数学表达,它们无懈可击,但是对于初学者来说,恐怕存在门槛。如果要通俗解释,必然只能侧重一个关键点,而出现漏洞。我想这也是教科书从来不把这些通俗解释写出来的原因吧——作者们不是不懂,而是怕写错。所以想深入理解傅里叶变换和小波变换的朋友还请认真学习教材,如果这篇文章能给一些初学者一点点帮助,我就心满意足了。

形象易懂讲解算法I——小波变换 https://zhuanlan.zhihu.com/p/22450818从傅里叶变换到小波变换,并不是一个完全抽象的东西,可以讲得很形象。小波变换有着明确的物理意义,如果我们从它的提出时所面对的问题看起,可以整理出非常清晰的思路。下面我就按照傅里叶-->短时傅里叶变换-->小波变换的顺序,讲一下为什么会出现小波这个东西、小波究竟是怎样的思路。(反正题主要求的是通俗形象,没说简短,希望不会太长不看。。)一、傅里叶变换关于傅里叶变换的基本概念在此我就不再赘述了,默认大家现在正处在理解了傅里叶但还没理解小波的道路上。(在第三节小波变换的地方我会再形象地讲一下傅里叶变换)下面我们主要讲傅里叶变换的不足。即我们知道傅里叶变化可以分析信号的频谱,那么为什么还要提出小波变换?答案在于,“对非平稳过程,傅里叶变换有局限性”。看如下一个简单的信号:做完FFT(快速傅里叶变换)后,可以在频谱上看到清晰的四条线,信号包含四个频率成分。一切没有问题。但是,如果是频率随着时间变化的非平稳信号呢?如上图,最上边的是频率始终不变的平稳信号。而下边两个则是频率随着时间改变的非平稳信号,它们同样包含和最上信号相同频率的四个成分。做FFT后,我们发现这三个时域上有巨大差异的信号,频谱(幅值谱)却非常一致。尤其是下边两个非平稳信号,我们从频谱上无法区分它们,因为它们包含的四个频率的信号的成分确实是一样的,只是出现的先后顺序不同。可见,傅里叶变换处理非平稳信号有天生缺陷。它只能获取一段信号总体上包含哪些频率的成分,但是对各成分出现的时刻并无所知。因此时域相差很大的两个信号,可能频谱图一样。然而平稳信号大多是人为制造出来的,自然界的大量信号几乎都是非平稳的,所以在比如生物医学信号分析等领域的论文中,基本看不到单纯傅里叶变换这样naive的方法。上图所示的是一个正常人的事件相关电位。对于这样的非平稳信号,只知道包含哪些频率成分是不够的,我们还想知道各个成分出现的时间。知道信号频率随时间变化的情况,各个时刻的瞬时频率及其幅值——这也就是时频分析。二、短时傅里叶变换(Short-time Fourier Transform, STFT)一个简单可行的方法就是——加窗。我又要套用方沁园同学的描述了,“把整个时域过程分解成无数个等长的小过程,每个小过程近似平稳,再傅里叶变换,就知道在哪个时间点上出现了什么频率了。”这就是短时傅里叶变换。看图:时域上分成一段一段做FFT,不就知道频率成分随着时间的变化情况了吗!用这样的方法,可以得到一个信号的时频图了:——此图像来源于“THE WAVELET TUTORIAL”图上既能看到10Hz, 25 Hz, 50 Hz, 100 Hz四个频域成分,还能看到出现的时间。两排峰是对称的,所以大家只用看一排就行了。是不是棒棒的?时频分析结果到手。但是STFT依然有缺陷。使用STFT存在一个问题,我们应该用多宽的窗函数?窗太宽太窄都有问题:窗太窄,窗内的信号太短,会导致频率分析不够精准,频率分辨率差。窗太宽,时域上又不够精细,时间分辨率低。(这里插一句,这个道理可以用海森堡不确定性原理来解释。类似于我们不能同时获取一个粒子的动量和位置,我们也不能同时获取信号绝对精准的时刻和频率。这也是一对不可兼得的矛盾体。我们不知道在某个瞬间哪个频率分量存在,我们知道的只能是在一个时间段内某个频带的分量存在。 所以绝对意义的瞬时频率是不存在的。)看看实例效果吧:——此图像来源于“THE WAVELET TUTORIAL”上图对同一个信号(4个频率成分)采用不同宽度的窗做STFT,结果如右图。用窄窗,时频图在时间轴上分辨率很高,几个峰基本成矩形,而用宽窗则变成了绵延的矮山。但是频率轴上,窄窗明显不如下边两个宽窗精确。所以窄窗口时间分辨率高、频率分辨率低,宽窗口时间分辨率低、频率分辨率高。对于时变的非稳态信号,高频适合小窗口,低频适合大窗口。然而STFT的窗口是固定的,在一次STFT中宽度不会变化,所以STFT还是无法满足非稳态信号变化的频率的需求。三、小波变换那么你可能会想到,让窗口大小变起来,多做几次STFT不就可以了吗?!没错,小波变换就有着这样的思路。但事实上小波并不是这么做的(关于这一点,方沁园同学的表述“小波变换就是根据算法,加不等长的窗,对每一小部分进行傅里叶变换”就不准确了。小波变换并没有采用窗的思想,更没有做傅里叶变换。)至于为什么不采用可变窗的STFT呢,我认为是因为这样做冗余会太严重,STFT做不到正交化,这也是它的一大缺陷。于是小波变换的出发点和STFT还是不同的。STFT是给信号加窗,分段做FFT;而小波直接把傅里叶变换的基给换了——将无限长的三角函数基换成了有限长的会衰减的小波基。这样不仅能够获取频率,还可以定位到时间了~【解释】来我们再回顾一下傅里叶变换吧,没弄清傅里叶变换为什么能得到信号各个频率成分的同学也可以再借我的图理解一下。傅里叶变换把无限长的三角函数作为基函数:这个基函数会伸缩、会平移(其实本质并非平移,而是两个正交基的分解)。缩得窄,对应高频;伸得宽,对应低频。然后这个基函数不断和信号做相乘。某一个尺度(宽窄)下乘出来的结果,就可以理解成信号所包含的当前尺度对应频率成分有多少。于是,基函数会在某些尺度下,与信号相乘得到一个很大的值,因为此时二者有一种重合关系。那么我们就知道信号包含该频率的成分的多少。仔细体会可以发现,这一步其实是在计算信号和三角函数的相关性。看,这两种尺度能乘出一个大的值(相关度高),所以信号包含较多的这两个频率成分,在频谱上这两个频率会出现两个峰。以上,就是粗浅意义上傅里叶变换的原理。如前边所说,小波做的改变就在于,将无限长的三角函数基换成了有限长的会衰减的小波基。这就是为什么它叫“小波”,因为是很小的一个波嘛~从公式可以看出,不同于傅里叶变换,变量只有频率ω,小波变换有两个变量:尺度a(scale)和平移量 τ(translation)。尺度a控制小波函数的伸缩,平移量 τ控制小波函数的平移。尺度就对应于频率(反比),平移量 τ就对应于时间。当伸缩、平移到这么一种重合情况时,也会相乘得到一个大的值。这时候和傅里叶变换不同的是,这不仅可以知道信号有这样频率的成分,而且知道它在时域上存在的具体位置。而当我们在每个尺度下都平移着和信号乘过一遍后,我们就知道信号在每个位置都包含哪些频率成分。看到了吗?有了小波,我们从此再也不害怕非稳定信号啦!从此可以做时频分析啦!做傅里叶变换只能得到一个频谱,做小波变换却可以得到一个时频谱!↑:时域信号↑:傅里叶变换结果——此图像来源于“THE WAVELET TUTORIAL”↑:小波变换结果小波还有一些好处,比如,我们知道对于突变信号,傅里叶变换存在吉布斯效应,我们用无限长的三角函数怎么也拟合不好突变信号:然而衰减的小波就不一样了:以上,就是小波的意义。以上只是用形象地给大家展示了一下小波的思想,希望能对大家的入门带来一些帮助。毕竟如果对小波一无所知,直接去看那些堆砌公式、照搬论文语言的教材,一定会痛苦不堪。在这里推荐几篇入门读物,都是以感性介绍为主,易懂但并不深入,对大家初步理解小波会很有帮助。文中有的思路和图也选自于其中:THE WAVELET TUTORIAL (强烈推荐,点击链接:Ihttp://users.rowan.edu/~polikar/WTtutorial.html)WAVELETS:SEEING THE FOREST AND THE TREESA Really Friendly Guide to WaveletsConceptual wavelets但是真正理解透小波变换,这些还差得很远。比如你至少还要知道有一个“尺度函数”的存在,它是构造“小波函数”的关键,并且是它和小波函数一起才构成了小波多分辨率分析,理解了它才有可能利用小波做一些数字信号处理;你还要理解离散小波变换、正交小波变换、二维小波变换、小波包……这些内容国内教材上讲得也很糟糕,大家就一点一点啃吧~一些问题的回答:关于海森堡不确定性原理不确定性原理,或者叫测不准原理,最早出自量子力学,意为在微观世界,粒子的位置与动量不可同时被确定。但是这个原理并不局限于量子力学,有很多物理量都有这样的特征,比如能量和时间、角动量和角度。体现在信号领域就是时域和频域。不过更准确一点的表述应该是:一个信号不能在时空域和频域上同时过于集中;一个函数时域越“窄”,它经傅里叶变换的频域后就越“宽”。如果有兴趣深入研究一下的话,这个原理其实非常耐人寻味。信号处理中的一些新理论在根本上也和它有所相连,比如压缩感知。如果你剥开它复杂的数学描述,最后会发现它在本质上能实现其实和不确定性原理密切相关。而且大家不觉得这样一些矛盾的东西在哲学意义上也很奇妙吗?关于正交化什么是正交化?为什么说小波能实现正交化是优势?简单说,如果采用正交基,变换域系数会没有冗余信息,变换前后的信号能量相等,等于是用最少的数据表达最大的信息量,利于数值压缩等领域。JPEG2000压缩就是用正交小波变换。比如典型的正交基:二维笛卡尔坐标系的(1,0)、(0,1),用它们表达一个信号显然非常高效,计算简单。而如果用三个互成120°的向量表达,则会有信息冗余,有重复表达。但是并不意味着正交一定优于不正交。比如如果是做图像增强,有时候反而希望能有一些冗余信息,更利于对噪声的抑制和对某些特征的增强。关于瞬时频率 原问题:图中时刻点对应一频率值,一个时刻点只有一个信号值,又怎么能得到他的频率呢? 很好的问题。如文中所说,绝对意义的瞬时频率其实是不存在的。单看一个时刻点的一个信号值,当然得不到它的频率。我们只不过是用很短的一段信号的频率作为该时刻的频率,所以我们得到的只是时间分辨率有限的近似分析结果。这一想法在STFT上体现得很明显。小波用衰减的基函数去测定信号的瞬时频率,思想也类似。(不过到了Hilbert变换,思路就不一样了,以后有机会细讲)关于小波变换的不足这要看和谁比了。A.作为图像处理方法,和多尺度几何分析方法(超小波)比:对于图像这种二维信号的话,二维小波变换只能沿2个方向进行,对图像中点的信息表达还可以,但是对线就比较差。而图像中最重要的信息恰是那些边缘线,这时候ridgelet(脊波), curvelet(曲波)等多尺度几何分析方法就更有优势了。B. 作为时频分析方法,和希尔伯特-黄变换(HHT)比:相比于HHT等时频分析方法,小波依然没脱离海森堡测不准原理的束缚,某种尺度下,不能在时间和频率上同时具有很高的精度;以及小波是非适应性的,基函数选定了就不改了。关于文中表述的严谨性评论中有不少朋友提到,我的一些表述不够精准。这是肯定的,并且我也是知道的。比如傅里叶变换的理解部分,我所说的那种“乘出一个大的值”的表述肯定是不够严谨的。具体我也在评论的回答中做了解释。我想说的是通俗易懂和精确严谨实在难以兼得,如果要追求严谨,最好的就是教科书上的数学表达,它们无懈可击,但是对于初学者来说,恐怕存在门槛。如果要通俗解释,必然只能侧重一个关键点,而出现漏洞。我想这也是教科书从来不把这些通俗解释写出来的原因吧——作者们不是不懂,而是怕写错。所以想深入理解傅里叶变换和小波变换的朋友还请认真学习教材,如果这篇文章能给一些初学者一点点帮助,我就心满意足了。 -

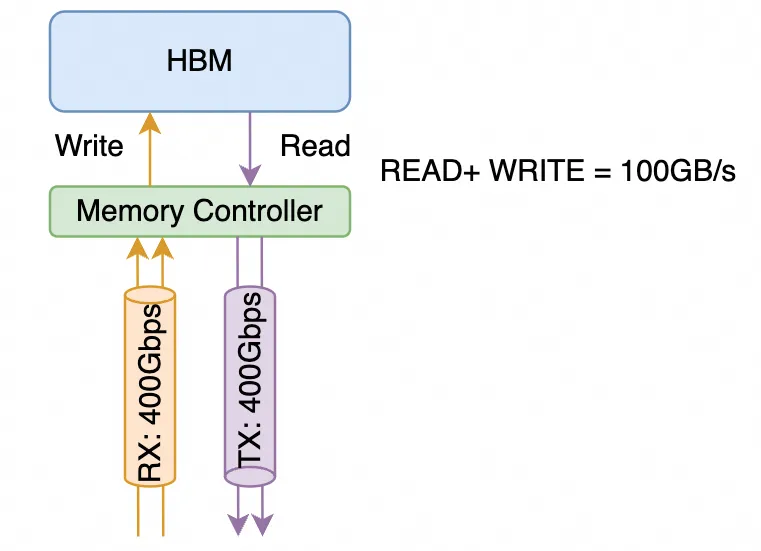

英伟达GB200架构解析1: 互联架构和未来演进 原创扎波特的橡皮擦zartbot2024年03月31日22:36浙江关于GB200想从下面几个方面来谈:NVL72和互联架构演进GH200/GB200在推荐系统等场景下的业务价值和商业逻辑GB200芯片的微架构的分析这是这个系列的第一篇,从互联架构上进行探讨。很多金融机构和分析师团队都在将英伟达和互联网兴起时的思科对比,那么本文在介绍完英伟达互联架构演进后也会穿插着把思科在互联网兴起时对互联系统的演进路径,以及当年的网络处理器(Network Processor,NP)和当下的DPU在体系结构上的进行对比,包括英伟达BlueField的片上网络还有很多Ezchip和Tilera这些网络处理器的影子,于是很多事情都会更加清晰了。互联网时代的思科和AI时代的英伟达,虽然时代不同,但有太多的路径重叠。本源是都在面临算力不够(思科是大量的查路由表访问内存)碰到内存墙后开始了一系列多芯片Scale-Out而产生互联架构的创新。特别是Bill Dally在互联网时代创办的Avici和当年华为的最顶级路由器NE5000有太多的关系,以及当下TPU的互联架构都是3D-Torus,而如今Bill Dally又是英伟达的首席科学家,未来的演进路线基本上也就清晰了。1.GB200互联架构解析1.1 NVLink带宽计算英伟达在对NVLINK的传输带宽计算和对于SubLink/Port/Lane的概念上存在很多混淆的地方,通常 单颗B200的NVLINK 5带宽是1.8TB/s,这是做计算的人算带宽通常按照内存带宽的算法以字节每秒(Byte/s)为单位。而在NVLink Switch上或者IB/Ethernet交换机和网卡上,是Mellanox的视角以网络带宽来计算的,通常是以传输的数据位为单位,即比特每秒(bit/s)。这里详细解释一下NVLINK的计算方式,NVLINK 3.0开始由四个差分对构成一个"sub-link"(英伟达经常对它用Port/Link,定义有些模糊),这4对差分信号线同时包含了接收和发送方向的信号线,而通常在计算网络带宽时,一个400Gbps的接口是指的同时能够收发400Gbps的数据,如下图所示它总共由4对差分信号线构成RX/TX各两对,从网络的视角来看是一个单向400Gbps的链路,而从内存带宽的视角是支持100GB/s的访存带宽。1.1.1 NVLINK 5.0 互联带宽在Blackwell这一代采用了224G Serdes,即sub-link的传输速率为200Gbps 4(4对差分线)/8 =100GB/s,从网络来看单向带宽为400Gbps。B200总共有18个sublink,因此构成了 100GB/s 18 = 1.8TB/s的带宽,而从网络的视角来看等同于9个单向400Gbps的接口。同理,在NVSwitch的介绍中声明的是 Dual 200Gb/sec SerDes构成一个400Gbps的Port为了方便后文的叙述,我们对这些术语进行统一定义如下:B200 NVLINK带宽为1.8TB/s,由18个Port构成,每个Port 100GB/s,由四对差分线构成,每个Port包含两组224Gbps的Serdes (2x224G PAM4 按照网络接口算为每端口单向400Gbps带宽)1.1.2 NVLINK 4.0 互联我们再补充一下Hopper,在NVLINK 4.0中采用了112G Serdes,即单对差分信号线可以传输100Gbps,累计单个NVLINK的Sub-link构成4x100Gbps= 50GB/s,支持NVLINK 4.0的Hopper这一代产品有18个sub-link(port),则单个H100支持50GB/s * 18 = 900GB/s,单机8卡利用4个NVswitch连接,如下图所示它还可以增加第二层交换机构成一个256卡的集群扩展接口采用OSFP的光模块如下图所示,OSFP光模块可以支持16对差分信号线, 因此单个OSPF支持4个NVLINK Port,即下图中NVLink Switch包含32个OSFP光模块接口连接器,累计支持32 * 4 = 128个NVLINK4 Port1.2 GB200 NVL72GB200 NVL72的Spec如下图所示,本文主要讨论NVLINK相关的问题一个GB200包含一颗Grace 72核的ARM CPU和2颗Blackwell GPU整个系统由Compute Tray和Switch Tray构成,一个Compute Tray包含两颗GB200子系统,累计4颗Blackwell GPU一个Switch Tray则包含两颗NVLINK Switch芯片,累计提供72 * 2 = 144个NVLINK Port,单颗芯片结构如下,可以看到上下各36个Port,带宽为7.2TB/s,按照网络的算法是28.8Tbps的交换容量,相对于当今最领先的51.2Tbps交换芯片小一些,但是需要注意到它由于实现SHARP(NVLS)这样的功能导致的整个机柜支持18个Compute Tray和9个Switch Tray,因此构成了一个单机柜72个Blackwell芯片全互联的架构,即NVL72.单个GB200子系统则包含2 * 18 = 36个NVLink5 Port,整个系统对外互联上并没有采用OSFP的光模块接口,而是直接通过一个后置的铜线背板连接,如下图所示:关于光退铜进这些金融机构分析师的说法其实是片面的,Hopper那一代是考虑的相对松耦合的连接方式,导致这些分析师过分的夸大了光模块的需求。而且当时对机柜散热部署等要求更加灵活。而这一代是在单机柜内整柜子交付,属于类似于IBM大型机的交付逻辑,自然而然的就选择了铜背板,同时单个B200功耗更高,整机液冷交付同时还有功耗约束,从功耗的角度来看换铜也可以降低很多。但是这并不代表未来都会是铜互联,后面章节会详细分析。整个NVL72的互联拓扑如下所示:每个B200有18个NVLINK Port,9个Switch Tray刚好共计18颗NVLINK Swtich 芯片,因此每个B200的Port连接一个NVSwitch芯片,累计整个系统单个NVSwitch有72个Port,故整个机器刚好构成NVL72,把72颗B200芯片全部连接起来。1.3 NVL576我们注意到在NVL72的机柜中,所有的交换机已经没有额外的接口互联构成更大规模的两层交换集群了,从英伟达官方的图片来看,16个机柜构成两排,虽然总计正好72 * 8个机柜构成576卡集群的液冷方案,单是从机柜连接线来看,这些卡更多的是通过Scale-Out RDMA网络互联的,而并不是通过Scale-Up的NVLINK网络互联对于一个32,000卡的集群也是通过这样的NVL72的机柜,一列9个机柜,4个NVL72和5个网络机柜,两列18个机柜构成一个Sub-Pod,并通过RDMA Scale-Out网络连接当然这个并不是所谓的NVL576,如果需要支持NVL576则需要每72个GB200配置18个NVSwitch,这样单机柜就放不下了,事实上我们注意到官方有这样一段话:官方说NVL72有单机柜版本,也有双机柜的版本,并且双机柜每个Compute Tray只有一个GB200子系统,另一方面我们注意到NVSwitch上有空余的铜缆接头,很有可能是为了不同的铜背板连接而特制的这些接口是不是会在铜互联背板上方再留一些OSFP Cage来用于第二层NVSwitch互联就不得而知了,但这样的方法有一个好处,单机柜的版本是Non-Scalable的,双机柜版本的是Scalable的,如下图所示:两个机柜的版本有18个NVSwitch Tray,可以背靠背互联构成NVL72.虽然交换机多了一倍,但是为以后扩展到576卡集群,每个交换机都提供了36个对外互联的Uplink,累计单个机柜有36 2 9 =648个上行端口,构成NVL576需要有16个机柜,则累计上行端口数为 648 * 16 = 10,368个,实际上可以由9个第二层交换平面构成,每个平面内又有36个子平面,由18个Switch Tray构成,NVL576的互联结构如下所示:1.4 从业务视角看到NVL576对于NVL576这样超大规模的单一NVLink Scale-Up组网是否真的有客户,我个人是持怀疑态度的,AWS也只选择了NVL72来提供云服务。主要的问题是2层组网的可靠性问题和弹性售卖的问题来看,NVL576并不是一个好的方案,系统复杂性太高。这样的方案存在的价值和当年思科搞CRS-1 MultiChassis集群类似,当年思科也是弄了一个16卡单个机柜,累计可以通过8个8个交换矩阵机柜互联72个线卡机柜来构成一个超大规模系统。主要是需要在市场上留一个技术领先的flag/benchmark,最终这样大规模的理论存在的系统埋单的用户几乎没有。另一方面是从下一代大模型本身的算力需求来看的,meta的论文《How to Build Low-cost Networks for Large Language Models (without Sacrificing Performance)?》[1]讨论过, 对于NVLink互联的Scale-Up网络,论文中将其称为一个(High Bandwidth Domain,HBD),对HBD内的卡的数目进行了分析:针对GPT-1T的模型来看,K=36以上时对性能提升相对于K=8还是很明显的,而对于K>72到K=576时的边际收益相对于系统的复杂性而言是得不偿失的,另一方面我们可以看到,当Scale-Up的NVLINK网络规模增大时,实际上HBD之间互联的RDMA带宽带来的性能收益在减小,最终的一个平衡就是通过NVL72并用RDMA Scale-Out来构建一个32,000卡的集群。互联系统演进:思科的故事这里用思科当年的发展路径来做对比具有很大的借鉴意义,前段时间有一篇公众号GlassEye的《英伟达的思科时刻》更多的是从金融市场和经济的视角来看待:第一,新技术的迭代(万维网 vs. 大模型)第二,卖铲子公司的垄断( 1993年思科的路由器/交换机 vs. 2023年英伟达的GPU)第三,标志应用的推出(1995年Netscape vs. 2023年的ChatGPT)--引用自GlassEye《英伟达的思科时刻》但是从技术的角度上,思科在那些年代的发展可以参考我以前写过的一篇文章《“网络编程” 还是 “可编程网络”?》2.1 算力/内存瓶颈带来的分布式架构最早的时候,思科的路由器是采用单颗PowerPC处理器执行转发的。随着互联网的爆发,对于路由查表等访存密集型计算导致了性能瓶颈,因此逐渐出现了进程交换/CEF等多种方式,通过数据总线将多个处理器连接起来:这些做法和早期的NVLINK 1.0 / NVLINK 2.0类似,例如Pascal那一代也是采用这种芯片间直接总线互联的方式2.2 交换矩阵出现1995年的时候,Nick Mckeown在论文"Fast Switched Backplan for a Gigabit Switched Router"中提出使用CrossBar交换机构成一个背板来支撑更高规模的Gigabit级的路由器,即后来的Cisco 12000系列高端路由器这些交换背板和当下的NVSwitch以及NVSwitch Tray构建的NVL8~NVL72的系统背后的原理是完全一致的。都是在单颗芯片遇到内存墙后,通过多个芯片互联构建一个更大规模的系统。Cisco12000的单机柜构造,中间是Switch Fabric和GB200机柜中间的9个Switch Tray类似,而顶部和底部都有8个业务线卡(LineCard)插槽,对应于GB200的每个Compute Tray。而这里面相对核心的技术是VOQ和iSLIP调度算法的设计,等价来说,当模型执行All-to-All时,有可能会多个B200同时向一个B200写入数据,因此会产生一定的头阻(Head-Of-Line Blocking,HOLB),聪明的人类总会在十字路口前后加宽一点作为缓冲,也就是所谓的Input Queue和Output Queue:可惜问题又来了,对于Output Queue而言, 虽然可以最大限度的使用带宽, 但需要队列缓存具有N * R的操作速度. 而对于Input Queue, 缓存可以用R的速度进行处理, 但是会遇到HOL Blocking的问题. 在一个IQ交换机上受制于HOL Blocking的crossbar最大吞吐量计算可得为 58.6%.解决IQ HOL Blocking问题的一种简单方案是使用虚拟输出排队(virtual output queueing , VOQ).在这种结构下,每个输入端口为每个输出设置一个队列,从而消除了HOL Blocking. 并保持缓存的操作速度为R.当然英伟达在NVLINK上采用了Credit based的设计方案,Credit的分发仲裁等都是国内一些做GPU创业的公司值得深入研究的问题。2.3 MultiStage多级架构和光互联演进而NVL576更像是思科在2003年推出的Carrier Routing System(CRS-1)当时也是面对互联网泡沫时期对带宽的巨大需求,构建了多级交换网络的系统。单个机柜3-stage的交换网络构建的Switch Tray,等同于当前的Non-Scalable的GB200 NVL72。而多机柜的结构则是对应于NVL576,当年思科也是将单机柜16个Linecard可以扩展到采用8个Fabric机柜+72个LineCard机柜来构建1152个LineCard的大规模集群,当年思科的内部连接也是采用光互联机箱之间的光连接器如下图所示:需要注意的是这个时间点还有一个人,那就是现在英伟达的首席科学家Bill Dally,它创建了Avici公司通过3D-Torus互联来构建Tbit级路由器3D-Torus的互联是不是又想到了Google的TPU?而后来华为也OEM了Avici这套系统并标记为NE5000售卖,再后来才是自己研发的核心路由器产品NE5000E。而同一个时代,Juniper的诞生也在核心路由器这个领域给思科带来很多压力。或许英伟达一家独大的日子接下来会引来更多的挑战者。另一方,MEMS的光交换机也是在那个年代引入的,和如今Google利用光交换机似乎也有一些似曾相识的感觉英伟达未来的演进年互联系统的大会HOTI上,Bil Dally做了一个Keynote: Accelerator Clusters,The New Suppercomputer[2]从片上网络和互联系统的角度来谈主要就是三大块内容:Topolgy:CLOS/3D-Torus/DragonflyRouting:Flow control不同的器件连接有不同的带宽和功耗:问题是如何有机的将它们组合起来,需要考虑功耗/成本/密度和连接距离等多个因素3.1 光互联通过这些维度的度量,Co-Package Optic DWDM成为一种选择:构建光互联的系统概念图如下:最终构建一个超大规模的光互联系统这一点上你会看到和思科当年做的CRS-1多机框系统几乎完全一致,GPU Rack等同于Cisco LineCard Chassis, Switch Rack等同于思科的Fabric Chassis,并且都是光互联,同时也使用了DWDM技术来降低连接复杂度并提升带宽芯片架构上则采用了Optical Engine作为chiplet进行互联而互联结构上则是更多的想去采用DragonFly拓扑并利用OCS光交换机至于FlowControl这些拥塞控制算法上,Bill在谈论一些类似于HOMA/NDP的机制,还有Adaptive Routing等。事实上并不用这么复杂,因为我们有更好的MultiPath CC算法,甚至不需要任何新的交换机特性支持。3.2 算法和特殊硬件结合另一方面来看,Transformer已经出来7年了,当然它是一个非常优秀的算法,既占满了算力有Compute Bound的算子,又有Memory Bound的算子,而整个工业界是否还有更精妙的算法呢?在《大模型时代的数学基础(4)》中我们介绍了一些算法,例如稀疏Attention的Monarch Mixer以及不需要Attention机制的Mamba/RMKV等模型,当然还有很多人正在研究的基于范畴论/代数几何/代数拓扑等算法下的优化。当然还有不同精度的数值格式,例如Blackwell开始支持的FP4/FP6格式,以及未来可能支持的Log8格式其实历史上思科也是依靠算法和特殊硬件来逐渐提高单芯片的算力摆脱复杂互联结构的。当时通过TreeBitMap这些路由查表算法在普通的DRAM上就可以支持大规模的路由查询同时借助于多核和片上网络等技术的发展,构建了超高性能的SPP/QFP/QFA网络处理器,而这些技术又辗转着在AWS Nitro/ Nvidia BlueField / Intel IPU等DPU处理器上再次出现。算法/算力和硬件的反复迭代才是时代发展的脉搏结论本文分析了最新的Blackwell这一代GPU的互联架构,并且针对《英伟达的思科时刻》对于两次科技浪潮中,两家公司面临单芯片算力跟不上爆发性需求后进行的分布式系统构建和互联架构的探索,并分析了英伟达首席科学家Bill Dally在2023 Hoti的演讲,基本上能够看清楚英伟达未来的发展路径了。但是我们同时也注意到,思科在互联网泡沫的高峰时期,也诞生了Juniper/Avici这样的公司,英伟达也是在那个年代作为挑战者战胜了3Dfx,后来又在专业领域战胜了SGI。任何一个时代都值得期待,而赢下来的不是单纯的堆料扩展,而是算法和算力结合硬件的创新。从挑战者来看,算力核本身抛开CUDA生态,其实难度并不大。最近Jim Keller和日韩一些HBM玩家动作频频,是否BUDA+RISC-V+HBM会成为一个新兴的力量。从互联系统替代IB/NVLINK来看,以太网已经有了51.2Tbps的交换芯片,基于以太网高速连接HBM的通信协议,并且支持SHARP这些随路计算在网计算的东西早在三年前NetDAM就设计好了《NETDAM-DPU新范式: 网络大坝和可编程存内计算》HBM通过以太网互联并高速低延迟访问内存的应用场景,很多人或许到了今日才会明白它的价值,毕竟只有经历过很多事情的老司机们才能更早的把这些看穿了:)参考资料[1]How to Build Low-cost Networks for Large Language Models (without Sacrificing Performance)?: https://arxiv.org/abs/2307.12169[2]HOTI 2023: Bill Dally Keynote: Accelerator Clusters: https://www.youtube.com/watch?v=napEsaJ5hMU来自微信

英伟达GB200架构解析1: 互联架构和未来演进 原创扎波特的橡皮擦zartbot2024年03月31日22:36浙江关于GB200想从下面几个方面来谈:NVL72和互联架构演进GH200/GB200在推荐系统等场景下的业务价值和商业逻辑GB200芯片的微架构的分析这是这个系列的第一篇,从互联架构上进行探讨。很多金融机构和分析师团队都在将英伟达和互联网兴起时的思科对比,那么本文在介绍完英伟达互联架构演进后也会穿插着把思科在互联网兴起时对互联系统的演进路径,以及当年的网络处理器(Network Processor,NP)和当下的DPU在体系结构上的进行对比,包括英伟达BlueField的片上网络还有很多Ezchip和Tilera这些网络处理器的影子,于是很多事情都会更加清晰了。互联网时代的思科和AI时代的英伟达,虽然时代不同,但有太多的路径重叠。本源是都在面临算力不够(思科是大量的查路由表访问内存)碰到内存墙后开始了一系列多芯片Scale-Out而产生互联架构的创新。特别是Bill Dally在互联网时代创办的Avici和当年华为的最顶级路由器NE5000有太多的关系,以及当下TPU的互联架构都是3D-Torus,而如今Bill Dally又是英伟达的首席科学家,未来的演进路线基本上也就清晰了。1.GB200互联架构解析1.1 NVLink带宽计算英伟达在对NVLINK的传输带宽计算和对于SubLink/Port/Lane的概念上存在很多混淆的地方,通常 单颗B200的NVLINK 5带宽是1.8TB/s,这是做计算的人算带宽通常按照内存带宽的算法以字节每秒(Byte/s)为单位。而在NVLink Switch上或者IB/Ethernet交换机和网卡上,是Mellanox的视角以网络带宽来计算的,通常是以传输的数据位为单位,即比特每秒(bit/s)。这里详细解释一下NVLINK的计算方式,NVLINK 3.0开始由四个差分对构成一个"sub-link"(英伟达经常对它用Port/Link,定义有些模糊),这4对差分信号线同时包含了接收和发送方向的信号线,而通常在计算网络带宽时,一个400Gbps的接口是指的同时能够收发400Gbps的数据,如下图所示它总共由4对差分信号线构成RX/TX各两对,从网络的视角来看是一个单向400Gbps的链路,而从内存带宽的视角是支持100GB/s的访存带宽。1.1.1 NVLINK 5.0 互联带宽在Blackwell这一代采用了224G Serdes,即sub-link的传输速率为200Gbps 4(4对差分线)/8 =100GB/s,从网络来看单向带宽为400Gbps。B200总共有18个sublink,因此构成了 100GB/s 18 = 1.8TB/s的带宽,而从网络的视角来看等同于9个单向400Gbps的接口。同理,在NVSwitch的介绍中声明的是 Dual 200Gb/sec SerDes构成一个400Gbps的Port为了方便后文的叙述,我们对这些术语进行统一定义如下:B200 NVLINK带宽为1.8TB/s,由18个Port构成,每个Port 100GB/s,由四对差分线构成,每个Port包含两组224Gbps的Serdes (2x224G PAM4 按照网络接口算为每端口单向400Gbps带宽)1.1.2 NVLINK 4.0 互联我们再补充一下Hopper,在NVLINK 4.0中采用了112G Serdes,即单对差分信号线可以传输100Gbps,累计单个NVLINK的Sub-link构成4x100Gbps= 50GB/s,支持NVLINK 4.0的Hopper这一代产品有18个sub-link(port),则单个H100支持50GB/s * 18 = 900GB/s,单机8卡利用4个NVswitch连接,如下图所示它还可以增加第二层交换机构成一个256卡的集群扩展接口采用OSFP的光模块如下图所示,OSFP光模块可以支持16对差分信号线, 因此单个OSPF支持4个NVLINK Port,即下图中NVLink Switch包含32个OSFP光模块接口连接器,累计支持32 * 4 = 128个NVLINK4 Port1.2 GB200 NVL72GB200 NVL72的Spec如下图所示,本文主要讨论NVLINK相关的问题一个GB200包含一颗Grace 72核的ARM CPU和2颗Blackwell GPU整个系统由Compute Tray和Switch Tray构成,一个Compute Tray包含两颗GB200子系统,累计4颗Blackwell GPU一个Switch Tray则包含两颗NVLINK Switch芯片,累计提供72 * 2 = 144个NVLINK Port,单颗芯片结构如下,可以看到上下各36个Port,带宽为7.2TB/s,按照网络的算法是28.8Tbps的交换容量,相对于当今最领先的51.2Tbps交换芯片小一些,但是需要注意到它由于实现SHARP(NVLS)这样的功能导致的整个机柜支持18个Compute Tray和9个Switch Tray,因此构成了一个单机柜72个Blackwell芯片全互联的架构,即NVL72.单个GB200子系统则包含2 * 18 = 36个NVLink5 Port,整个系统对外互联上并没有采用OSFP的光模块接口,而是直接通过一个后置的铜线背板连接,如下图所示:关于光退铜进这些金融机构分析师的说法其实是片面的,Hopper那一代是考虑的相对松耦合的连接方式,导致这些分析师过分的夸大了光模块的需求。而且当时对机柜散热部署等要求更加灵活。而这一代是在单机柜内整柜子交付,属于类似于IBM大型机的交付逻辑,自然而然的就选择了铜背板,同时单个B200功耗更高,整机液冷交付同时还有功耗约束,从功耗的角度来看换铜也可以降低很多。但是这并不代表未来都会是铜互联,后面章节会详细分析。整个NVL72的互联拓扑如下所示:每个B200有18个NVLINK Port,9个Switch Tray刚好共计18颗NVLINK Swtich 芯片,因此每个B200的Port连接一个NVSwitch芯片,累计整个系统单个NVSwitch有72个Port,故整个机器刚好构成NVL72,把72颗B200芯片全部连接起来。1.3 NVL576我们注意到在NVL72的机柜中,所有的交换机已经没有额外的接口互联构成更大规模的两层交换集群了,从英伟达官方的图片来看,16个机柜构成两排,虽然总计正好72 * 8个机柜构成576卡集群的液冷方案,单是从机柜连接线来看,这些卡更多的是通过Scale-Out RDMA网络互联的,而并不是通过Scale-Up的NVLINK网络互联对于一个32,000卡的集群也是通过这样的NVL72的机柜,一列9个机柜,4个NVL72和5个网络机柜,两列18个机柜构成一个Sub-Pod,并通过RDMA Scale-Out网络连接当然这个并不是所谓的NVL576,如果需要支持NVL576则需要每72个GB200配置18个NVSwitch,这样单机柜就放不下了,事实上我们注意到官方有这样一段话:官方说NVL72有单机柜版本,也有双机柜的版本,并且双机柜每个Compute Tray只有一个GB200子系统,另一方面我们注意到NVSwitch上有空余的铜缆接头,很有可能是为了不同的铜背板连接而特制的这些接口是不是会在铜互联背板上方再留一些OSFP Cage来用于第二层NVSwitch互联就不得而知了,但这样的方法有一个好处,单机柜的版本是Non-Scalable的,双机柜版本的是Scalable的,如下图所示:两个机柜的版本有18个NVSwitch Tray,可以背靠背互联构成NVL72.虽然交换机多了一倍,但是为以后扩展到576卡集群,每个交换机都提供了36个对外互联的Uplink,累计单个机柜有36 2 9 =648个上行端口,构成NVL576需要有16个机柜,则累计上行端口数为 648 * 16 = 10,368个,实际上可以由9个第二层交换平面构成,每个平面内又有36个子平面,由18个Switch Tray构成,NVL576的互联结构如下所示:1.4 从业务视角看到NVL576对于NVL576这样超大规模的单一NVLink Scale-Up组网是否真的有客户,我个人是持怀疑态度的,AWS也只选择了NVL72来提供云服务。主要的问题是2层组网的可靠性问题和弹性售卖的问题来看,NVL576并不是一个好的方案,系统复杂性太高。这样的方案存在的价值和当年思科搞CRS-1 MultiChassis集群类似,当年思科也是弄了一个16卡单个机柜,累计可以通过8个8个交换矩阵机柜互联72个线卡机柜来构成一个超大规模系统。主要是需要在市场上留一个技术领先的flag/benchmark,最终这样大规模的理论存在的系统埋单的用户几乎没有。另一方面是从下一代大模型本身的算力需求来看的,meta的论文《How to Build Low-cost Networks for Large Language Models (without Sacrificing Performance)?》[1]讨论过, 对于NVLink互联的Scale-Up网络,论文中将其称为一个(High Bandwidth Domain,HBD),对HBD内的卡的数目进行了分析:针对GPT-1T的模型来看,K=36以上时对性能提升相对于K=8还是很明显的,而对于K>72到K=576时的边际收益相对于系统的复杂性而言是得不偿失的,另一方面我们可以看到,当Scale-Up的NVLINK网络规模增大时,实际上HBD之间互联的RDMA带宽带来的性能收益在减小,最终的一个平衡就是通过NVL72并用RDMA Scale-Out来构建一个32,000卡的集群。互联系统演进:思科的故事这里用思科当年的发展路径来做对比具有很大的借鉴意义,前段时间有一篇公众号GlassEye的《英伟达的思科时刻》更多的是从金融市场和经济的视角来看待:第一,新技术的迭代(万维网 vs. 大模型)第二,卖铲子公司的垄断( 1993年思科的路由器/交换机 vs. 2023年英伟达的GPU)第三,标志应用的推出(1995年Netscape vs. 2023年的ChatGPT)--引用自GlassEye《英伟达的思科时刻》但是从技术的角度上,思科在那些年代的发展可以参考我以前写过的一篇文章《“网络编程” 还是 “可编程网络”?》2.1 算力/内存瓶颈带来的分布式架构最早的时候,思科的路由器是采用单颗PowerPC处理器执行转发的。随着互联网的爆发,对于路由查表等访存密集型计算导致了性能瓶颈,因此逐渐出现了进程交换/CEF等多种方式,通过数据总线将多个处理器连接起来:这些做法和早期的NVLINK 1.0 / NVLINK 2.0类似,例如Pascal那一代也是采用这种芯片间直接总线互联的方式2.2 交换矩阵出现1995年的时候,Nick Mckeown在论文"Fast Switched Backplan for a Gigabit Switched Router"中提出使用CrossBar交换机构成一个背板来支撑更高规模的Gigabit级的路由器,即后来的Cisco 12000系列高端路由器这些交换背板和当下的NVSwitch以及NVSwitch Tray构建的NVL8~NVL72的系统背后的原理是完全一致的。都是在单颗芯片遇到内存墙后,通过多个芯片互联构建一个更大规模的系统。Cisco12000的单机柜构造,中间是Switch Fabric和GB200机柜中间的9个Switch Tray类似,而顶部和底部都有8个业务线卡(LineCard)插槽,对应于GB200的每个Compute Tray。而这里面相对核心的技术是VOQ和iSLIP调度算法的设计,等价来说,当模型执行All-to-All时,有可能会多个B200同时向一个B200写入数据,因此会产生一定的头阻(Head-Of-Line Blocking,HOLB),聪明的人类总会在十字路口前后加宽一点作为缓冲,也就是所谓的Input Queue和Output Queue:可惜问题又来了,对于Output Queue而言, 虽然可以最大限度的使用带宽, 但需要队列缓存具有N * R的操作速度. 而对于Input Queue, 缓存可以用R的速度进行处理, 但是会遇到HOL Blocking的问题. 在一个IQ交换机上受制于HOL Blocking的crossbar最大吞吐量计算可得为 58.6%.解决IQ HOL Blocking问题的一种简单方案是使用虚拟输出排队(virtual output queueing , VOQ).在这种结构下,每个输入端口为每个输出设置一个队列,从而消除了HOL Blocking. 并保持缓存的操作速度为R.当然英伟达在NVLINK上采用了Credit based的设计方案,Credit的分发仲裁等都是国内一些做GPU创业的公司值得深入研究的问题。2.3 MultiStage多级架构和光互联演进而NVL576更像是思科在2003年推出的Carrier Routing System(CRS-1)当时也是面对互联网泡沫时期对带宽的巨大需求,构建了多级交换网络的系统。单个机柜3-stage的交换网络构建的Switch Tray,等同于当前的Non-Scalable的GB200 NVL72。而多机柜的结构则是对应于NVL576,当年思科也是将单机柜16个Linecard可以扩展到采用8个Fabric机柜+72个LineCard机柜来构建1152个LineCard的大规模集群,当年思科的内部连接也是采用光互联机箱之间的光连接器如下图所示:需要注意的是这个时间点还有一个人,那就是现在英伟达的首席科学家Bill Dally,它创建了Avici公司通过3D-Torus互联来构建Tbit级路由器3D-Torus的互联是不是又想到了Google的TPU?而后来华为也OEM了Avici这套系统并标记为NE5000售卖,再后来才是自己研发的核心路由器产品NE5000E。而同一个时代,Juniper的诞生也在核心路由器这个领域给思科带来很多压力。或许英伟达一家独大的日子接下来会引来更多的挑战者。另一方,MEMS的光交换机也是在那个年代引入的,和如今Google利用光交换机似乎也有一些似曾相识的感觉英伟达未来的演进年互联系统的大会HOTI上,Bil Dally做了一个Keynote: Accelerator Clusters,The New Suppercomputer[2]从片上网络和互联系统的角度来谈主要就是三大块内容:Topolgy:CLOS/3D-Torus/DragonflyRouting:Flow control不同的器件连接有不同的带宽和功耗:问题是如何有机的将它们组合起来,需要考虑功耗/成本/密度和连接距离等多个因素3.1 光互联通过这些维度的度量,Co-Package Optic DWDM成为一种选择:构建光互联的系统概念图如下:最终构建一个超大规模的光互联系统这一点上你会看到和思科当年做的CRS-1多机框系统几乎完全一致,GPU Rack等同于Cisco LineCard Chassis, Switch Rack等同于思科的Fabric Chassis,并且都是光互联,同时也使用了DWDM技术来降低连接复杂度并提升带宽芯片架构上则采用了Optical Engine作为chiplet进行互联而互联结构上则是更多的想去采用DragonFly拓扑并利用OCS光交换机至于FlowControl这些拥塞控制算法上,Bill在谈论一些类似于HOMA/NDP的机制,还有Adaptive Routing等。事实上并不用这么复杂,因为我们有更好的MultiPath CC算法,甚至不需要任何新的交换机特性支持。3.2 算法和特殊硬件结合另一方面来看,Transformer已经出来7年了,当然它是一个非常优秀的算法,既占满了算力有Compute Bound的算子,又有Memory Bound的算子,而整个工业界是否还有更精妙的算法呢?在《大模型时代的数学基础(4)》中我们介绍了一些算法,例如稀疏Attention的Monarch Mixer以及不需要Attention机制的Mamba/RMKV等模型,当然还有很多人正在研究的基于范畴论/代数几何/代数拓扑等算法下的优化。当然还有不同精度的数值格式,例如Blackwell开始支持的FP4/FP6格式,以及未来可能支持的Log8格式其实历史上思科也是依靠算法和特殊硬件来逐渐提高单芯片的算力摆脱复杂互联结构的。当时通过TreeBitMap这些路由查表算法在普通的DRAM上就可以支持大规模的路由查询同时借助于多核和片上网络等技术的发展,构建了超高性能的SPP/QFP/QFA网络处理器,而这些技术又辗转着在AWS Nitro/ Nvidia BlueField / Intel IPU等DPU处理器上再次出现。算法/算力和硬件的反复迭代才是时代发展的脉搏结论本文分析了最新的Blackwell这一代GPU的互联架构,并且针对《英伟达的思科时刻》对于两次科技浪潮中,两家公司面临单芯片算力跟不上爆发性需求后进行的分布式系统构建和互联架构的探索,并分析了英伟达首席科学家Bill Dally在2023 Hoti的演讲,基本上能够看清楚英伟达未来的发展路径了。但是我们同时也注意到,思科在互联网泡沫的高峰时期,也诞生了Juniper/Avici这样的公司,英伟达也是在那个年代作为挑战者战胜了3Dfx,后来又在专业领域战胜了SGI。任何一个时代都值得期待,而赢下来的不是单纯的堆料扩展,而是算法和算力结合硬件的创新。从挑战者来看,算力核本身抛开CUDA生态,其实难度并不大。最近Jim Keller和日韩一些HBM玩家动作频频,是否BUDA+RISC-V+HBM会成为一个新兴的力量。从互联系统替代IB/NVLINK来看,以太网已经有了51.2Tbps的交换芯片,基于以太网高速连接HBM的通信协议,并且支持SHARP这些随路计算在网计算的东西早在三年前NetDAM就设计好了《NETDAM-DPU新范式: 网络大坝和可编程存内计算》HBM通过以太网互联并高速低延迟访问内存的应用场景,很多人或许到了今日才会明白它的价值,毕竟只有经历过很多事情的老司机们才能更早的把这些看穿了:)参考资料[1]How to Build Low-cost Networks for Large Language Models (without Sacrificing Performance)?: https://arxiv.org/abs/2307.12169[2]HOTI 2023: Bill Dally Keynote: Accelerator Clusters: https://www.youtube.com/watch?v=napEsaJ5hMU来自微信 -

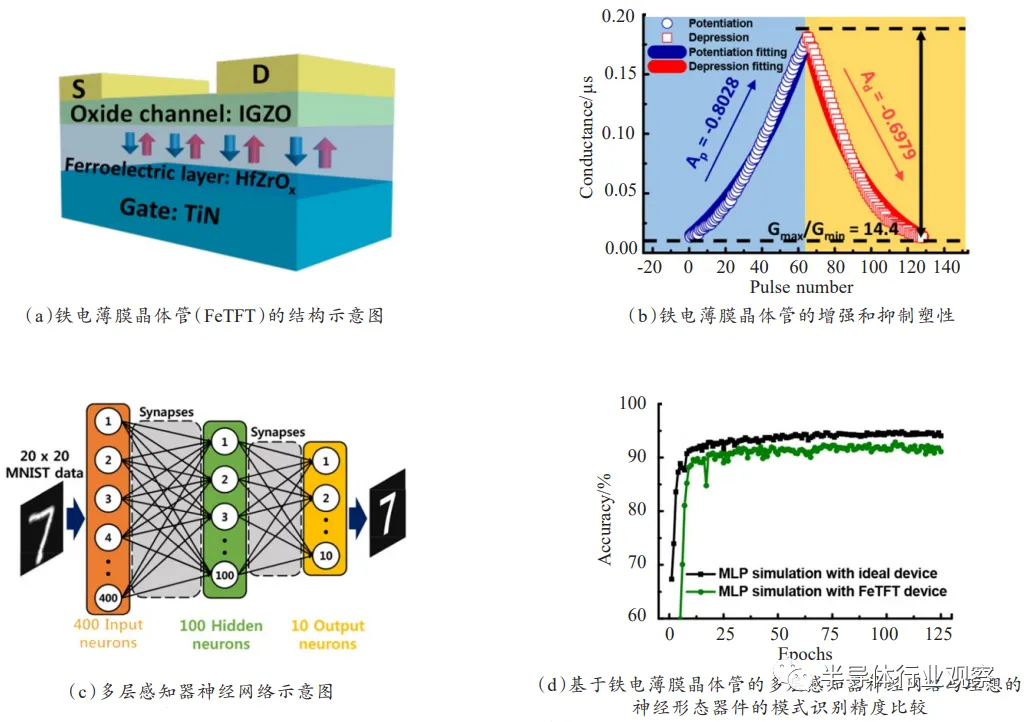

神经形态晶体管研究进展 光刻人的世界2020年12月28日18:45神经元是大脑信息处理的基本单元,突触则是神经元之间在功能上发生联系的部位,也是信息传递和处理的关键部位。从底层出发研制具有生物突触和神经元功能的固态器件与系统对于研制超低功耗“类脑芯片”和实现全新一代人工智能系统意义十分重大。其中多端口晶体管由于其独特的电容耦合机制,多元化的界面调控手段和丰富的材料选择等优点,最近引起了科研界的广泛关注。从铁电突触晶体管、双电层/电化学突触晶体管、光电突触晶体管3类器件介绍近年来神经形态晶体管的研究进展,并总结该类器件面临的机遇和挑战。引言人脑是一个大规模并行计算结构,通过突触传递输入信息,能够实时处理接收到的各类信息,每个突触事件仅消耗1~10fJ,其高效和超低功耗一直为全人类所惊叹。大脑由大约1011个神经元组成,每个神经元可以通过1000多个突触与其他神经元连接。这些神经元和突触连接排列在三维空间中,形成了一个复杂的信息处理神经网络,它是人类所有感知、思想和行为的基础。在当今社会,人类已经步入了大数据时代,每天都要进行大量的数据传输和储存,这些工作如今主要都依赖于传统的计算机处理系统,其功不可没,然而传统计算机也面临着许多 的挑战。(1)构筑传统计算机的主要器件CMOS晶体管发展到当前工艺已经很难遵循摩尔定律了,传统计算机很难实现更小尺寸的高效处理模式;(2)传统计算机的构架遵循冯·诺依曼结构,其结构中CPU和内存是分开的。两者之间的大量数据传输不利于计算系统的效率提升,功耗降低,体积减小,即达到了“冯·诺依曼瓶颈”[1]。众所周知,相对于传统计算机,人脑能够快速处理复杂信息,同时学习和记忆,并且能耗非常低,体积很小,其高效和强大引起了众多科学家的关注[2-3]。受大脑这样的生物超级计算机的强大能力鼓舞,利用电子器件构筑一个能够自学习低功耗类脑计算机的神经形态工程理念于几十年前就已经提出来了。发展至今,科学家们提出类脑神经计算可由两类途径实现,分别是软件模拟和硬件实现。目前基于软件模拟的方法往往需要消耗大量的能量和占据很大的空间。IBM曾用超级计算机(Blue Gene)来进行软件模拟,其电功耗高达1.4兆瓦[4]。此外,软件模拟的途径是通过计算机大量串行处理进行计算,因此不能高效地模拟神经网络的并行处理机制。基于硬件实现的途径是利用高集成度的电子器件来构建人工神经元网络。突触作为神经元的功能连接部位,能够高效地处理和传递信息,也是计算和学习的基本单位。因此,设计并制备出具有突触功能的电子器件装置对于实现类脑计算体系存在着非凡的意义。神经系统中,突触作为一种特殊的结构,它能够将电信号转化为化学信号,再转化为电信号,从而进行神经元之间的信息传递。根据后神经元响应的电信号不同可分为兴奋性突触电流/后电位(excitatory post-synaptic current/potential, EPSC/EPSP)和抑制性突触后电流/后电位(inhibitory postsynaptic current/potential,IPSC/IPSP)。前神经元和后神经元之间的连接强度被定义为突触权重,许多突触权重变化的研究统称为突触可塑性。根据保留时间的不同,突触可塑性可以简单地分为短程可塑性(short-term plasticity,STP)和长程可塑性(long-term plasticity, LTP)。STP发生在毫秒到分钟之间,是神经网络计算功能的生理基础。双脉冲易化(pairedpulse facilitation,PPF)是STP的一种表现形式,当第二个输入信号跟第一个输入信号时,突触后信号被放大。PPF可参与一些神经元任务,如简单的学习和信息处理。LTP表示持续几个小时或更长时间的可塑性变化,将给神经网络带来永久性的变化,从而使大脑能够存储大量的信息。Hebb假设认为持续和反复刺激突触前神经元,可导致突触后神经元突触传递效率的提高[5]。时间依赖突触可塑性(spiketiming-dependent plasticity,STDP)概念的提出进一步完善了Hebb的理论,指出突触前和突触后尖峰的时间关系可以调节突触权重[6]。除STDP外,频率依赖突触可塑性(spike-rate-dependent plasticity,SRDP)是另一个基本的学习机制,突触权重可以通过控制突触前脉冲频率来改变,高于特定频率阈值的高频突触前脉冲将引起突触后反应增强,而低于特定频率阈值的低频突触前脉冲会导致这种反应的抑制[7]。近年来,大量的电子器件被构筑出来模拟突触塑性以期其在类脑神经形态工程中的突破和应用。其中两端器件如忆阻器、相变存储器、原子开关等,由于它们具有结构简单、功耗低、物理体积小、易于大规模集成等优点已被广泛应用于模仿突触功能[8-9]。然而,这些器件很难同时执行信号传输和自学习功能,大大阻碍它们在先进类脑神经形态工程中的进一步应用[10]。三端/多端突触晶体管不仅克服了二端器件很难同时执行信号传输和自学习的缺点,还具有稳定性好、测试参数相对可控、运行机制清晰、可由多种材料构成等优点[11]。通过适当的材料选择和结构设计,三端/多端突触晶体管可以将外界的刺激(光、压力、温度等)转换成电信号,从而实现对外界环境直接响应的人工突触[12-13]。此外,模拟需要多端操作的并行学习和树突整合可以很容易地在基于三端/多端突触晶体管的人工突触中实现,这为开发具有较少神经元件的神经网络开辟了可能 性。因此,三端/多端突触晶体管可能比其他类型的器件更适合模拟突触功能。基于三端/多端突触晶体管的人工突触的研究越来越受到重视,但这一领域还处于起步阶段。本文综述和讨论了包括铁电突触晶体管、双电层/电化学突触晶体管和光电突触晶体管在内的三端/多端晶体管的工作原理和近年来的主要进展,以期对今后的研究有所启发。铁电突触晶体管铁电场效应晶体管(ferroelectric field-effect transistors,FeFETs)具有编程速度快、无损读出、开关比大、低功耗等优点,在人造电子突触仿生学方面有广泛的应用前景[14]。FeFETs应用于突触晶体管的工作原理是由于具有高介电常数能够自发极化的铁电材料作为其绝缘层,通过电压可以调控铁电材料的极 化状态,从而改变沟道载流子密度,而沟道电导非易失性改变实现了突触功能的模拟。此外,每一个脉冲电压都会改变铁电材料的细微极化状态,因此也会在沟道中得到不同的电导。利用这种多级化非易失性的变化可用于记录突触权重,许多科学家利用这一性质模拟了突触的STDP学习功能。2014年,Kaneko等[15]提出基于ZnO/Pr(Zr,Ti)O3/SrRuO3/Pt结构的铁电晶体管构筑神经网络。利用铁电材料Pr(Zr,Ti)O3(PZT)的多极化效应可调控晶体 管中沟道ZnO中电导的大小,这种调节变化可保持很长的时间,类似长程可塑性。使用此铁电晶体管成功地模拟了生物突触中的STDP学习规则,此外为了实现模式识别功能利用此器件搭建了神经网络结构,其原理是由于STDP学习规则进行了学习和记忆,其网络结构中的权值分布会发生改变,进行识别操作过程时,当输入一定模式时,神经网络会召回最接近曾经学习过的模式形成输出信号。虽然基于PZT的铁电晶体管在模拟突触方面表现出很好的塑性行为,但其固有的铅含量,不可避免地会给人类和环境带来危害。近年,Kim等[16]报道了一种如图1(a)所示以24nm HfZrOx为铁电绝缘层10nm InGaZnO为沟道层的突触晶体管。HfZrOx首先由ALD在280℃的腔体温度下沉积,然后在400℃氮气 氛围下退火1min形成铁电绝缘层。通过改变施加的电压脉冲的振幅,可以精细地调制通道的电导。此外,如图(1b)所示构筑的铁电晶体管表现出很好的增强和抑制塑性,例如高的模拟状态数(64)、良好的线性(Ap,-0.8028;Ad,-0.6979)和Gmax/Gmin比值>10。受其良好性能的鼓舞,设计了一个如图1(c)所示具有400个输入神经元、100个隐藏神经元和10个输出神经元的多层感知器神经网络。经过多阶段训练,实现了手写数字91.1%的识别准确度,接近理想突触神经网络94.1%的识别率,如图1(d)所示。氧化物铁电材料通常需要较高的结晶温度,这限制了其在塑料基板上大面积电子器件的应用。此外,其固有刚性也限制了其在柔性和可穿戴电子设备领域的应用。图1.无机铁电晶体管的神经形态应用与氧化物铁电体相比,有机铁电体可以克服氧化物铁电体的这方面的局限性。Jang等[17]报道了以有机PVDF-TrFE薄膜作为铁电绝缘层的超薄(500nm) 突触晶体管,如图(2a)所示。它可以独立存在,无需基底或封装层,利用简单的干法剥离和粘贴方法,所制备的器件可以稳定地转移到如图2(b)所示的二氧化硅、纺织品、牙刷、果冻、糖果等各种均匀和不均匀的基板上。通过对有机铁电绝缘层的极化调节,成功地实现了短程可塑性(STP),长程可塑性(LTP),长程抑制(LTD),时间依赖突触可塑性(STDP)等重要的突触功能,如图2(c)~(e)。为了验证超薄有机突触晶体管能在苛刻的弯曲条件下保持其稳定的突触功能,他们在R=50µm,ε=0.48%的折叠条件下测试了器件突触的突触塑性,图2(f)展现了苛刻的弯曲条件下施加6000个脉冲器件表现 出稳定的长期增强和长期抑制突触塑性。这项工作表明了超薄柔性有机人工铁电突触器件是实现未来可穿戴智能电子的关键技术之一。图2.超薄柔性有机铁电晶体管的突触塑性双电层/电化学突触晶体管双电层/电化学突触晶体管(electric-double-layer/electrochemical synaptic transistors)由于其栅介质层中离子可以自由移动,在电场诱导作用下进行迁移、积聚进而改变沟道导电特性。晶体管中的栅电极可以看作是突触前膜,沟道层可以看作是突触后膜,沟道电导可以看作是突触重量,这种类似于突触的工作模式使其在低功耗,柔性突触仿生学领域展现了广泛的应用前景。在外电场作用下界面处由于静电耦合积累电荷层的晶体管称为双电层薄膜晶体管[18],而对于有些离子可渗透的半导体,当施加的外电场过大,离子可从栅介质层中渗透进沟道层中进而改变沟道电导的工作原理是电化学掺杂,其晶体管称之为电化学薄膜晶体管[19]。突触电子学中常用易失性的静电耦合作用和非易失性的电化学掺杂/脱掺杂这两种机制来模拟突触的短程和长程可塑性。此外,双电层/电化学突触晶体管一个出众的方面是在低功耗方面已经能够实现生物学中单个突触事件的能量消耗(大约10fJ/spike)[20],这为实现超低功耗突触器件打下了坚实的基础。无机半导体具有良好的稳定性和较高的载流子迁移率,在三端双电层/电化学突触晶体管中彰显着巨大的应用潜力。近年来用于突触器件的无机半导体材料有很多,包括碳纳米管[20],石墨烯[21],二硫化钼[22],铟锌氧[11],铟镓锌氧[23]等。碳纳米管具有纳米尺寸和独特的电学性质,被认为是未来电子电路中 替代硅的潜在材料。2013年,Kim等[20]报道了以碳纳米管作为沟道层,氢掺杂聚乙二醇单甲醚(PEG)作为栅介质层的突触晶体管,其结构示意图如图3 (a)所示。在施加电压脉冲之前,聚合物中的氢离子是随机分布的。当正电压脉冲作用于碳纳米管突触器件的栅极时,氢离子开始定向移动,最终由于静电 耦合效应形成双电层,进而调节碳纳米管沟道中载流子浓度,导致沟道电流的增加。脉冲结束后,由于浓度梯度的存在,电解质/沟道界面附近的氢离子会从界面处开始慢慢扩散,使沟道电流继续减小直至稳定,如图3(b)。基于离子迁移和非易失性静电耦合效应,该晶体管成功地模拟了EPSC、PPF、动态逻 辑、长程增强塑性、长程抑制塑性和STDP等典型的突触功能。图3.碳纳米管突触晶体管示意图及突触前电压脉冲触发的EPSC石墨烯具有优异的热稳定性、超薄的层状结构和良好的力学性能,是一种应用于高集成度柔性电子器件领域的理想材料。Sharbati等[21]利用聚氧化乙烯(PEO)中的LiClO4作为固体电解质,被剥落下来的石墨烯原子层作为沟道层。栅电极模拟突触前膜,固体电解质模拟神经元间传导离子的突触裂缝。通过控制石墨烯层中锂离子的浓度,实现了对石墨烯器件电导的可逆精确调节。在这个电化学石墨烯突触器件中模拟了突触的增强和抑制塑性。当向石墨烯器件施加50pA、10ms的输入电流时,沟道电阻立即下降30Ω,然后衰减到稳定状态,此时的电阻比初始状态小10Ω,这种现象模拟了兴奋性突触的突触权重变化,电导的永久性变化是锂掺杂的非易失性造成的。在应用一系列不同参数的脉冲后,还观察到LTP和LTD行为。STDP塑性也在这种电化学突触中通过应用双脉冲可编程方案得到了证实。种种突触行为的成功模拟预示着这种电化学石墨烯突触晶体管有可能成为神经形态计算的硬件实现方案之一。近年来,原子层状的2D材料已经引起了纳米器件的广泛关注,在各类先进的电子器件方面表现出很好的应用前景。Jiang等[22]制备了一种以聚乙烯醇(PVA)质子传导电解质为栅介质层的多栅调控2D MoS2突触晶体管。共面金属电极2DMoS2分别被认为是突触前膜和突触后膜。通过调控多个突触前输入端可以在这样的2D MoS2神经形态晶体管中进行时空耦合。基于2D MoS2的器件中已经成功模拟了EPSC、PPF、动态滤波器、时空信号树状积分等突触行为。此外,乘法神经编码和神经元增益调制也被成功证明。这种2D MoS2神经形态装置对于在二维纳米级神经形态认知系统中实现有趣的人工智能具有重要意义,如方向选择性、目标识别、感知处理等。金属氧化物半导体由于其高的载流子迁移率、优异的光学透明性、良好的稳定性以及可大面积制备等优点使其成为人工突触晶体管的潜在候选沟道材料。其中铟锌氧(IZO)和铟镓锌氧(IGZO)是应用最广泛的氧化物材料。Zhu等[11]提出了一种基于磷(P)掺杂纳米颗粒SiO2薄膜质子横向耦合效应的IZO突触晶体管。如图4(a)所示,不需要底部导电,并且栅极电压可以仅通过一个横向双电(EDL)电容直接耦合到IZO半导体实现横向调控。使用该器件模拟了一系列短程可塑性行为,包括两个脉冲时间间隔Δtpre越小可获得较高的PPF数值的双脉冲易化(如图(4b)所示),高频信号越多,突触权重在短时间内增加越多的高通滤波行为(如图4(c)所示)以及时空相关动态逻辑测试(如图4(d))。此外,这种横向耦合的突触晶体管可以很容易扩展到多个输入栅极,以构建突触相互作用的功能。这里提出的这种基于质子传导电解质的横向耦合IZO晶体管对突触电子学和神经形态工程具有重要意义。图4.横向耦合IZO晶体管的突触塑性2019年,He等[23]展示了一种基于金属氧化物铟镓锌氧(IGZO)多端口神经晶体管,模拟了不同时空输入模式的树突辨别,其结构示意图如图5(a)所 示。首先,该器件模拟了突触可塑性的调节行为,如双脉冲易化和高通时间滤波。然后在多端神经晶体管中实现了不同时空输入模式的树突识别,说明它可以作为基本皮层计算的时空信息处理单元,大大减小神经形态系统的规模和复杂性,提高人工神经网络的效率。最后,作为一个时空信息处理的例子,一个有趣的工作——通过基于这种多端IGZO神经晶体管的人工神经网络来模拟人脑的声音定位功能被提出来,利用双耳效应在人脑中定位声音的示意图如图5(b)所示。如图5(c)所示,当声音来自右侧方向时,POSTN1首先处理弱突触传递的信号,然后处理强突触传递的信号。POSTN2首先处理强突触传递的信号,然后处理弱突触传递的信号。因此,在最后一个PREN信号出现时,POSTN1(IPOST1)的突触后电流幅度大于POSTN2(IPOST2)。同样,如果声音是从左方发出的,则IPOST2的振幅大于IPOST1的振幅。最后一个PREN信号时,IPOST和IPOST1的振幅与PREN 2和PREN1峰值(TPREN2-TPREN1)的相对时间和声音方位角的比值如图(5d)所示。最后一个PREN信号时,IPOST1和IPOST2之间的差变随着PREN 1和PREN 2峰值相对时间的变化。当时差为0ms时,比率为1。当时间差在25~1000ms变化时,比值大于1,并且随着时间差的增大而增大。当时间差在-1000~-25ms之间变化时,比值小于1,并且随着时间差的增大而增大。这种与时间相关的识别表明了人工神经网络对声音方位角的检测功能。图5.多端双电层晶体管神经形态模拟有机半导体由于其成本低,化学多功能性强,柔性可弯曲,易于加工等优点被国内外各大实验室所研究,其也被用来制备有机电化学晶体管来模拟突触塑性。2015年,Gkoupidenis等[24]首次报道了使用PEDOT:PSS作为沟道层,KCl 电解质作为栅绝缘层的低功耗有机电化学神经形态晶体管。电解液中的离子由于电场作用会被注入到PEDOT:PSS聚合物中以改变其空穴掺杂水平,从而调节流经通道的空穴电流。当脉冲电压被移除时,由于先前注入的离子会扩散回电解质,PEDOT:PSS将恢复到原来的状态。基于PEDOT:PSS的电化学突触晶体管实现了双脉冲抑制(PPD)和动态滤波特性等典型的突触行为。近年来,Qian等[25]将聚(3-己基噻吩)(P3HT)旋涂在SiO2/Si衬底上作为沟道层,热沉积了金作为源、漏和栅电极,最后将配比的离子凝胶作为栅绝缘层制备了有机电化学晶体管,其结构如图6(a)所示。利用施加在栅极的脉冲电压作为输入刺激,沟道电导变化代表突出权重。该突触晶体管成功模拟了后突触兴奋电流(如图(6b)所示),当施加脉冲栅电压,阴离子从离子凝胶移动到栅绝缘层与沟道层的界面处,从而形成EDL。因此,P3HT中的空穴积聚在半导体和离子凝胶的界面上,导致通道电导增加。在脉冲电压撤去后,阴离子开始扩散,回到它们在离子凝胶中的初始分布,因此PSC恢复到原来的状态。基于P3HT的有机电化学晶体管也实现了自我调整(如图6(c)所示)。当一系列的输入脉冲电压施加时,双脉冲易化出现在前两个尖峰上,但随后EPSC值随着脉冲电压的持续增加而减少,这种现象与生物兴奋性突触的适应性相同。此外,如图6(d)所示该突触晶体管还实现了双栅调控的OR逻辑。图6.有机电化学晶体管的突触塑性模拟光电突触晶体管光电突触晶体管(optoelectronic synaptic transistors)是构成神经形态计算系统的另一基本方法,利用这种新型人工装置模拟突触行为具有高效节能的优势。相对于传统的突触装置需要额外的传感器来进行光电转换。而以光为输入信号的光电神经形态器件,不仅将视觉、信息处理和记忆结合在一起,而且具有带宽高、鲁棒性强、并行性好等优点,适用于模拟人眼视网膜神经元等功能[26-27]。2018年,Yang等[28]制造了基于铟镓锌氧(IGZO)双电层(EDL)晶体管的电阻负载反相器用于光电突触器件应用。这种光电人工突触装置可以模拟突触 行为,如兴奋性突触后电位(EPSP),双脉冲易化(PPF)和长期可塑性等。整个器件可以看作是一种低压光电人工突触。其施加在IGZO通道层上的光脉冲 ,输出电位和沟道的电导改变分别被视为输入信号,突触后电位(PSP)和突触权重,其结构示意图如图7(a)所示。图7(b)的上部和下部分别描绘了不同光脉冲功率(232mw/cm²在和176mw/cm²)在不同栅压下刺激的EPSP曲线。从图中观察到更强的光脉冲信号导致更显著的反应,输出端电位从基态急 剧升高,达到峰值后,突触后电位逐渐回落。在这个过程中,通道电阻被输入光脉冲调制,导致输出电压相应地改变。图7(c)显示了两个连续的突触前光脉 冲触发的EPSP(PPF塑性行为),由第二个突触前光脉冲触发的EPSP的振幅比由第一个突触前光脉冲刺激的EPSP的振幅大1.37倍。图7(d)描述了不同 栅压下,刺激次数累积时,器件突触权重变化情况。图7.基于铟镓锌氧(IGZO)双电层(EDL)晶体管的光电突触塑性同年,Dai等[29]报道了一种有机场效应晶体管的光电突触装置,该装置使用聚丙烯腈(PAN)膜作为介电和电荷捕获层,PAN介质薄膜的强极性官能团可以在沟道/栅介质的界面上产生很强的电荷俘获效应。界面处光生电荷的捕获和去捕获过程为OFET提供了突触行为,如EPSC和PPF。此外,通过调节光刺激参数(包括光脉冲宽度、强度和光脉冲数量),实现了类似于人脑的记忆和学习行为。包括EPSC衰退和遗忘等行为。Wang等[30]报道了一种无机卤化物钙钛矿(CsPbBr3)量子点(QD)的光子突触。将厚度为30nm的CsPbBr3QD层旋涂到100nm厚的SiO2的Si衬底上。超薄的聚甲基丙烯酸甲酯(PMMA)层被旋涂在顶部作为钝化层。然后在PMMA顶部沉积p型并五苯作为半导体沟道。最后通过热蒸发和掩膜版技术沉积金的源、漏电极,该器件结构如图8(a)所示。器件中CsPbBr3量子点和半导体层之间形成的异质结构是该器件的光学可编程和电可擦除特性的基础。在栅极作用下,CsPbBr3量子点中的光生空穴通过能带调控下很容易注入到半导体层,而电子则留在CsPbBr3量子点中。而由于势阱的存在,留在CsPbBr3量子点中电子能保持较长时间从而产生类似突触的记忆效应。想要完全擦除这种记忆效应则需要加一个足够的负栅极电压。利用这种特性,通过光脉冲宽度、光脉冲强度和光脉冲波长等光刺激参数,有效地模拟了EPSC、PPF、PPD等突触塑性,如图(8b)~(d)所示。此报道中光电突触装置的制备有望为今后神经形态器件的设计提供新的思路。图8.有机场效应晶体管的光电突触塑性总结和展望近10年来,在神经形态工程的飞速发展进程中,基于硬件途径实现人造突触得到了充分的重视和研究,从模拟生物突触或神经元行为,到复杂的神经形 态计算 ,都取得了显著的进展。其中三端口晶体管由于具有稳定性好、测试参数相对可控、运行机制清晰、可由多种材料构成等优点在众多被构筑出来用以模拟突触行为的电子器件中脱颖而出。通过适当的材料选择和结构设计,三端/多端突触晶体管可以将外界的刺激(光、压力、温度等)转换成电信号,从而实现对外界环境直接响应的人工突触。此外,三端/多端突触晶体管还具有同时执行信号传输和自学习的优势,而且模拟需要多端操作的并行学习和树突整合可以很容易地在基于三端/多端突触晶体管的人工突触中实现,这为开发具有较少神经元件 的神经网络开辟了可能性。本文讨论了包括铁电突触晶体管、双电层/电化学突触晶体管和光电突触晶体管在内的三端/多端晶体管近年来的最新进展。它们有各自的优缺点,其中铁电场效应晶体管具有编程速度快、无损读出、开关比大、低功耗等优点。然而部分改变铁电材料的极化状态通常需要较大的工作电压,铁电材料的稳定极化状态使其易于实现LTP,但是很难实现STP;双电层/电化学突触晶体管在实现逻辑功能、树突整合和人工树突神经元方面优于其他类型的器件。此外,双电层/电化学晶体管的低压工作特性也为实现超低能耗的突触器件提供了可能。然而,器件的耐用性和电解质的不稳定性可能是双电层/电化学突触晶体管的主要限制;在光电突触晶体管方面,以光为输入信号的光电神经形态器件,不仅将视觉、信息处理和记忆结合在一起,而且具有带宽高、鲁棒性强、并行性好等优点,适用于模拟人眼视网膜神经元等功能。然而,利用光信号实现抑制性突触仍然是一个很大的挑战。这些器件各有优缺点,根据特定应用程序的要求,一种类型的器件可以优先于其他类型的器件。神经形态工程旨在构建具有超低能耗的鲁棒类脑计算机,利用新兴的突触装置来实现人工神经网络已经有了很多成功的尝试,然而神经形态器件领域所面临的一些主要问题和挑战仍需要我们不断进取努力。例如:目前所报道的突触器件模拟的小部分突触行为,完整的人造突触功能还需进一步研究完善;对于能够模拟生物神经元信息处理功能的神经形态器件的研究还仅限于少数报道,迫切需要更 深入的研究;目前科学对人脑的功能和运行机制的了解还在初步阶段。虽然目前这一领域还处于起步阶段,但是在未来,期待利用大量人造突触晶体管模拟类似于感官(视觉、听觉、运动、嗅觉)这样复杂的人类神经系统。相信通过物理、化学、材料学、计算机和医学等科学领域的跨学科交流,类脑神经形态工程将获得不断的革新进步和应用,先进的人工智能系统将促进人类在服务行业、个人医疗、教育和交通等领域的生活。文献引用:朱力,万青. 神经形态晶体管研究进展[J]. 微纳电子与智能制造, 2019, 1(4): 39-50.Research progress of neuromorphic transistors[J]. Micro/nano Electronics and Intelligent Manufacturing, 2019, 1(4): 39-50.《微纳电子与智能制造》刊号:CN10-1594/TN主管单位:北京电子控股有限责任公司主办单位:北京市电子科技科技情报研究所北京方略信息科技有限公司投稿邮箱:tougao@mneim.org.cn(网站:www.mneim.org.cn)参考文献:[1] BACKUS J. Can programming be liberated from the von Neumann style? a function style and its algebra of programs[J]. Communications of the ACM, 1978, 21(8): 613-641. [2] DRACHMAN D A. Do wo have brain to spare[J]. Neurology, 2005, 64 (12):2004-2005. [3] FURBER S. To build a brain[J]. Spectrum IEEE, 2012, 49(8): 44-49. [4]MARKRAM H. The blue brain project[J]. Nature Reviews Neuroscience, 2006, 7(2): 153-160.[5] MARKRAM H, GERSTNER W, SJÖSTRÖM P J. A history of spike-timing-dependent plasticity[J]. Frontiers in Synaptic Neuroscience, 2011, 3(4): 4. [6] CAPORALE N, DAN Y. Spike timing-dependent plasticity: a hebbian learning rule[J]. Annual Review of Neuroscience, 2008, 31(1): 25-46. [7] RACHMUTH G, SHOUVAL H Z, BEAR M F, et al. A biophysically- based neuromorphic model of spike rate- and timing-dependent plasticity[J]. Proceedings of the National Academy of Sciences, 2011, 108(49): E1266-74. [8] PREZIOSO M, MERRIKH-BAYAT F, HOSKINS B D, et al. Training and operaion of an integrated neuromorphic network based on metal- oxide memeristors[J]. Nature, 2015, 521(7550): 61-64. [9 ] XU W, LEE Y, MIN S Y, et al. Simple, inexpensive, and rapid approch to fabricate cross- shaped memristors using an inorganic- nanowire- alignment technique and a one- step reduction process[J]. Advanced Materials, 2016, 28(3): 527-532. [10] NISHITANI Y, KANEKO Y, UEDA M, et al. Three-terminal ferroelectric synapse device with concurrent learning function for artficial neural networks[J]. Journal of Applied Physics, 2012, 111(12): 124108-1-124108-6. [11] ZHU L Q, WAN C J, GUO L Q, et al. Artificial synapse network on inorganic proton conductor for neuromorphic systems[J]. Nature Communications, 2014, 5: 3158. [12] DAI S, WU X, LIU D, et al. Light- stimulated synaptic devices utilizing interfacial effect of organic field-effect transistors[J]. ACS Applied Materials & Interfaces, 2018, 10 (25): 21472-21480. [13] WANG K, DAI S, ZHAO Y, et al. Light-stimulated synaptic transistors fabricated by a facile solution process based on inorganic perovskite quantum dots and organic semiconductors[J]. Small, 2019, 15(11): 1900010-1-19000010-8. [14] MILLER S L, MCWHORTER P J. Physics of the ferroelectric nonvolatile memory field effect transistor[J]. Journal of Applied Physics, 1992, 72(12): 5999-6010. [15] KANEKO Y, NISHITANI Y, UEDA M. Ferroelectric artificial synapases for recognition of a multishaded image [J]. IEEE Transactions on Electron Devices, 2014, 61 (8): 2827-2833. [16] KIM M K, LEE J S. Ferroelectric analog synaptic transistors[J]. Nano Letters, 2019, 19(3): 2044-2050. [17] JANG S, JANG S, LEE E -H, et al. Ultrathin comformable organic artificial synapses for wearable intelligent device applicatios[J]. ACS Applied Materials & Interfaces, 2019, 11(1): 1071-1080. [18] MIN Y, AKBULULUT M, SANGORO J R, et al. Measurement of forces across room temperature ionic liquids between mica surfaces[J]. The Journal of Physical Chemistry C, 2009, 113(37): 16445-16449. [19] KIM S H, HONG K, XIE W, et al. Electrolyte-gated transistors for organic and printed electronics[J]. Advanced Materials, 2013, 25(13): 1822-1846. [20] KIM K, CHEN C L, TRUONG Q, et al. A carbon nanotube synapse with dynamic logic and learning[J]. Advanced Materials, 2013, 25(12): 1693-1698. [21] SHARBATI M T, DU Y, TORRES J, et al. Low- power, electrochemically tunable graphene synapses for neuromorphic computing[J]. Advanced Materials, 2018, 30 (36): 1802353. [22] JIANG J, GUO J, WAN X, et al. 2D MoS2 neuromorphic devices for brain- like computational systems[J]. Small, 2017, 13(29): 1900933-1-1700933-11. [23] HE Y L, NIE S, LIU R, et al. Spatiotemporal information processing emulated by multiterminal neuro- transistor networks[J]. Advanced Materials, 2019, 31(21): 1900903-1-19000903-8. [24] GKOUPIDENIS P, SCHAEFER N, GARLAN B, et al. Neuromorphic functions in PEDOT: PSS organic electrochemical transistors[J]. Advanced Materials, 2015, 27 (44): 7176-7180. [25] QIAN C, SUN J, KONG L A, et al. Artificial synapses based on in- plane gate organic electrochemical transistors[J]. ACS Applied Materials & Interfaces, 2016, 8 (39): 26169-26175. [26] KURAMOCHI E, NOZAKI K, SHINYA A, et al. Largescale integration of wavelength- addressable all- optical memories on a photonic crystal chip[J]. Nature Photonics, 2014, 8(6): 474-481. [27] GHOLIPOUR B, BASTOCK P, CRAIG C, et al. Amorphous metal- sulphide microfibers enable photonic synapses for brain-like computing[J]. Advanced Optical Materials, 2015, 3(5): 635-641. [28] LI H K, CHEN T P, LIU P, et al. A light-stimulated synaptic transistor with synaptic plasticity and memory functions based on InGaZnOx- Al2O3 thin film structure [J]. Journal of Applied Physics, 2016, 119(24): 244505- 1-244505-5. [29] DAI S L,WU X H, LIU D P, et al. Light-stimulated synaptic devices utilizing interfacial effect of organic fieldeffect transistors[J]. Applied Materials & Interfaces, 2018, 10(25): 21472-21480. [30] WANG Y, LV Z Y, CHEN J R, et al. Photonic synapses based on inorganic perovskite quantum dots for neuromorphic computing[J]. Advanced Materials, 2018, 30 (38): 1802883-1-1802883-9.来自微信

神经形态晶体管研究进展 光刻人的世界2020年12月28日18:45神经元是大脑信息处理的基本单元,突触则是神经元之间在功能上发生联系的部位,也是信息传递和处理的关键部位。从底层出发研制具有生物突触和神经元功能的固态器件与系统对于研制超低功耗“类脑芯片”和实现全新一代人工智能系统意义十分重大。其中多端口晶体管由于其独特的电容耦合机制,多元化的界面调控手段和丰富的材料选择等优点,最近引起了科研界的广泛关注。从铁电突触晶体管、双电层/电化学突触晶体管、光电突触晶体管3类器件介绍近年来神经形态晶体管的研究进展,并总结该类器件面临的机遇和挑战。引言人脑是一个大规模并行计算结构,通过突触传递输入信息,能够实时处理接收到的各类信息,每个突触事件仅消耗1~10fJ,其高效和超低功耗一直为全人类所惊叹。大脑由大约1011个神经元组成,每个神经元可以通过1000多个突触与其他神经元连接。这些神经元和突触连接排列在三维空间中,形成了一个复杂的信息处理神经网络,它是人类所有感知、思想和行为的基础。在当今社会,人类已经步入了大数据时代,每天都要进行大量的数据传输和储存,这些工作如今主要都依赖于传统的计算机处理系统,其功不可没,然而传统计算机也面临着许多 的挑战。(1)构筑传统计算机的主要器件CMOS晶体管发展到当前工艺已经很难遵循摩尔定律了,传统计算机很难实现更小尺寸的高效处理模式;(2)传统计算机的构架遵循冯·诺依曼结构,其结构中CPU和内存是分开的。两者之间的大量数据传输不利于计算系统的效率提升,功耗降低,体积减小,即达到了“冯·诺依曼瓶颈”[1]。众所周知,相对于传统计算机,人脑能够快速处理复杂信息,同时学习和记忆,并且能耗非常低,体积很小,其高效和强大引起了众多科学家的关注[2-3]。受大脑这样的生物超级计算机的强大能力鼓舞,利用电子器件构筑一个能够自学习低功耗类脑计算机的神经形态工程理念于几十年前就已经提出来了。发展至今,科学家们提出类脑神经计算可由两类途径实现,分别是软件模拟和硬件实现。目前基于软件模拟的方法往往需要消耗大量的能量和占据很大的空间。IBM曾用超级计算机(Blue Gene)来进行软件模拟,其电功耗高达1.4兆瓦[4]。此外,软件模拟的途径是通过计算机大量串行处理进行计算,因此不能高效地模拟神经网络的并行处理机制。基于硬件实现的途径是利用高集成度的电子器件来构建人工神经元网络。突触作为神经元的功能连接部位,能够高效地处理和传递信息,也是计算和学习的基本单位。因此,设计并制备出具有突触功能的电子器件装置对于实现类脑计算体系存在着非凡的意义。神经系统中,突触作为一种特殊的结构,它能够将电信号转化为化学信号,再转化为电信号,从而进行神经元之间的信息传递。根据后神经元响应的电信号不同可分为兴奋性突触电流/后电位(excitatory post-synaptic current/potential, EPSC/EPSP)和抑制性突触后电流/后电位(inhibitory postsynaptic current/potential,IPSC/IPSP)。前神经元和后神经元之间的连接强度被定义为突触权重,许多突触权重变化的研究统称为突触可塑性。根据保留时间的不同,突触可塑性可以简单地分为短程可塑性(short-term plasticity,STP)和长程可塑性(long-term plasticity, LTP)。STP发生在毫秒到分钟之间,是神经网络计算功能的生理基础。双脉冲易化(pairedpulse facilitation,PPF)是STP的一种表现形式,当第二个输入信号跟第一个输入信号时,突触后信号被放大。PPF可参与一些神经元任务,如简单的学习和信息处理。LTP表示持续几个小时或更长时间的可塑性变化,将给神经网络带来永久性的变化,从而使大脑能够存储大量的信息。Hebb假设认为持续和反复刺激突触前神经元,可导致突触后神经元突触传递效率的提高[5]。时间依赖突触可塑性(spiketiming-dependent plasticity,STDP)概念的提出进一步完善了Hebb的理论,指出突触前和突触后尖峰的时间关系可以调节突触权重[6]。除STDP外,频率依赖突触可塑性(spike-rate-dependent plasticity,SRDP)是另一个基本的学习机制,突触权重可以通过控制突触前脉冲频率来改变,高于特定频率阈值的高频突触前脉冲将引起突触后反应增强,而低于特定频率阈值的低频突触前脉冲会导致这种反应的抑制[7]。近年来,大量的电子器件被构筑出来模拟突触塑性以期其在类脑神经形态工程中的突破和应用。其中两端器件如忆阻器、相变存储器、原子开关等,由于它们具有结构简单、功耗低、物理体积小、易于大规模集成等优点已被广泛应用于模仿突触功能[8-9]。然而,这些器件很难同时执行信号传输和自学习功能,大大阻碍它们在先进类脑神经形态工程中的进一步应用[10]。三端/多端突触晶体管不仅克服了二端器件很难同时执行信号传输和自学习的缺点,还具有稳定性好、测试参数相对可控、运行机制清晰、可由多种材料构成等优点[11]。通过适当的材料选择和结构设计,三端/多端突触晶体管可以将外界的刺激(光、压力、温度等)转换成电信号,从而实现对外界环境直接响应的人工突触[12-13]。此外,模拟需要多端操作的并行学习和树突整合可以很容易地在基于三端/多端突触晶体管的人工突触中实现,这为开发具有较少神经元件的神经网络开辟了可能 性。因此,三端/多端突触晶体管可能比其他类型的器件更适合模拟突触功能。基于三端/多端突触晶体管的人工突触的研究越来越受到重视,但这一领域还处于起步阶段。本文综述和讨论了包括铁电突触晶体管、双电层/电化学突触晶体管和光电突触晶体管在内的三端/多端晶体管的工作原理和近年来的主要进展,以期对今后的研究有所启发。铁电突触晶体管铁电场效应晶体管(ferroelectric field-effect transistors,FeFETs)具有编程速度快、无损读出、开关比大、低功耗等优点,在人造电子突触仿生学方面有广泛的应用前景[14]。FeFETs应用于突触晶体管的工作原理是由于具有高介电常数能够自发极化的铁电材料作为其绝缘层,通过电压可以调控铁电材料的极 化状态,从而改变沟道载流子密度,而沟道电导非易失性改变实现了突触功能的模拟。此外,每一个脉冲电压都会改变铁电材料的细微极化状态,因此也会在沟道中得到不同的电导。利用这种多级化非易失性的变化可用于记录突触权重,许多科学家利用这一性质模拟了突触的STDP学习功能。2014年,Kaneko等[15]提出基于ZnO/Pr(Zr,Ti)O3/SrRuO3/Pt结构的铁电晶体管构筑神经网络。利用铁电材料Pr(Zr,Ti)O3(PZT)的多极化效应可调控晶体 管中沟道ZnO中电导的大小,这种调节变化可保持很长的时间,类似长程可塑性。使用此铁电晶体管成功地模拟了生物突触中的STDP学习规则,此外为了实现模式识别功能利用此器件搭建了神经网络结构,其原理是由于STDP学习规则进行了学习和记忆,其网络结构中的权值分布会发生改变,进行识别操作过程时,当输入一定模式时,神经网络会召回最接近曾经学习过的模式形成输出信号。虽然基于PZT的铁电晶体管在模拟突触方面表现出很好的塑性行为,但其固有的铅含量,不可避免地会给人类和环境带来危害。近年,Kim等[16]报道了一种如图1(a)所示以24nm HfZrOx为铁电绝缘层10nm InGaZnO为沟道层的突触晶体管。HfZrOx首先由ALD在280℃的腔体温度下沉积,然后在400℃氮气 氛围下退火1min形成铁电绝缘层。通过改变施加的电压脉冲的振幅,可以精细地调制通道的电导。此外,如图(1b)所示构筑的铁电晶体管表现出很好的增强和抑制塑性,例如高的模拟状态数(64)、良好的线性(Ap,-0.8028;Ad,-0.6979)和Gmax/Gmin比值>10。受其良好性能的鼓舞,设计了一个如图1(c)所示具有400个输入神经元、100个隐藏神经元和10个输出神经元的多层感知器神经网络。经过多阶段训练,实现了手写数字91.1%的识别准确度,接近理想突触神经网络94.1%的识别率,如图1(d)所示。氧化物铁电材料通常需要较高的结晶温度,这限制了其在塑料基板上大面积电子器件的应用。此外,其固有刚性也限制了其在柔性和可穿戴电子设备领域的应用。图1.无机铁电晶体管的神经形态应用与氧化物铁电体相比,有机铁电体可以克服氧化物铁电体的这方面的局限性。Jang等[17]报道了以有机PVDF-TrFE薄膜作为铁电绝缘层的超薄(500nm) 突触晶体管,如图(2a)所示。它可以独立存在,无需基底或封装层,利用简单的干法剥离和粘贴方法,所制备的器件可以稳定地转移到如图2(b)所示的二氧化硅、纺织品、牙刷、果冻、糖果等各种均匀和不均匀的基板上。通过对有机铁电绝缘层的极化调节,成功地实现了短程可塑性(STP),长程可塑性(LTP),长程抑制(LTD),时间依赖突触可塑性(STDP)等重要的突触功能,如图2(c)~(e)。为了验证超薄有机突触晶体管能在苛刻的弯曲条件下保持其稳定的突触功能,他们在R=50µm,ε=0.48%的折叠条件下测试了器件突触的突触塑性,图2(f)展现了苛刻的弯曲条件下施加6000个脉冲器件表现 出稳定的长期增强和长期抑制突触塑性。这项工作表明了超薄柔性有机人工铁电突触器件是实现未来可穿戴智能电子的关键技术之一。图2.超薄柔性有机铁电晶体管的突触塑性双电层/电化学突触晶体管双电层/电化学突触晶体管(electric-double-layer/electrochemical synaptic transistors)由于其栅介质层中离子可以自由移动,在电场诱导作用下进行迁移、积聚进而改变沟道导电特性。晶体管中的栅电极可以看作是突触前膜,沟道层可以看作是突触后膜,沟道电导可以看作是突触重量,这种类似于突触的工作模式使其在低功耗,柔性突触仿生学领域展现了广泛的应用前景。在外电场作用下界面处由于静电耦合积累电荷层的晶体管称为双电层薄膜晶体管[18],而对于有些离子可渗透的半导体,当施加的外电场过大,离子可从栅介质层中渗透进沟道层中进而改变沟道电导的工作原理是电化学掺杂,其晶体管称之为电化学薄膜晶体管[19]。突触电子学中常用易失性的静电耦合作用和非易失性的电化学掺杂/脱掺杂这两种机制来模拟突触的短程和长程可塑性。此外,双电层/电化学突触晶体管一个出众的方面是在低功耗方面已经能够实现生物学中单个突触事件的能量消耗(大约10fJ/spike)[20],这为实现超低功耗突触器件打下了坚实的基础。无机半导体具有良好的稳定性和较高的载流子迁移率,在三端双电层/电化学突触晶体管中彰显着巨大的应用潜力。近年来用于突触器件的无机半导体材料有很多,包括碳纳米管[20],石墨烯[21],二硫化钼[22],铟锌氧[11],铟镓锌氧[23]等。碳纳米管具有纳米尺寸和独特的电学性质,被认为是未来电子电路中 替代硅的潜在材料。2013年,Kim等[20]报道了以碳纳米管作为沟道层,氢掺杂聚乙二醇单甲醚(PEG)作为栅介质层的突触晶体管,其结构示意图如图3 (a)所示。在施加电压脉冲之前,聚合物中的氢离子是随机分布的。当正电压脉冲作用于碳纳米管突触器件的栅极时,氢离子开始定向移动,最终由于静电 耦合效应形成双电层,进而调节碳纳米管沟道中载流子浓度,导致沟道电流的增加。脉冲结束后,由于浓度梯度的存在,电解质/沟道界面附近的氢离子会从界面处开始慢慢扩散,使沟道电流继续减小直至稳定,如图3(b)。基于离子迁移和非易失性静电耦合效应,该晶体管成功地模拟了EPSC、PPF、动态逻 辑、长程增强塑性、长程抑制塑性和STDP等典型的突触功能。图3.碳纳米管突触晶体管示意图及突触前电压脉冲触发的EPSC石墨烯具有优异的热稳定性、超薄的层状结构和良好的力学性能,是一种应用于高集成度柔性电子器件领域的理想材料。Sharbati等[21]利用聚氧化乙烯(PEO)中的LiClO4作为固体电解质,被剥落下来的石墨烯原子层作为沟道层。栅电极模拟突触前膜,固体电解质模拟神经元间传导离子的突触裂缝。通过控制石墨烯层中锂离子的浓度,实现了对石墨烯器件电导的可逆精确调节。在这个电化学石墨烯突触器件中模拟了突触的增强和抑制塑性。当向石墨烯器件施加50pA、10ms的输入电流时,沟道电阻立即下降30Ω,然后衰减到稳定状态,此时的电阻比初始状态小10Ω,这种现象模拟了兴奋性突触的突触权重变化,电导的永久性变化是锂掺杂的非易失性造成的。在应用一系列不同参数的脉冲后,还观察到LTP和LTD行为。STDP塑性也在这种电化学突触中通过应用双脉冲可编程方案得到了证实。种种突触行为的成功模拟预示着这种电化学石墨烯突触晶体管有可能成为神经形态计算的硬件实现方案之一。近年来,原子层状的2D材料已经引起了纳米器件的广泛关注,在各类先进的电子器件方面表现出很好的应用前景。Jiang等[22]制备了一种以聚乙烯醇(PVA)质子传导电解质为栅介质层的多栅调控2D MoS2突触晶体管。共面金属电极2DMoS2分别被认为是突触前膜和突触后膜。通过调控多个突触前输入端可以在这样的2D MoS2神经形态晶体管中进行时空耦合。基于2D MoS2的器件中已经成功模拟了EPSC、PPF、动态滤波器、时空信号树状积分等突触行为。此外,乘法神经编码和神经元增益调制也被成功证明。这种2D MoS2神经形态装置对于在二维纳米级神经形态认知系统中实现有趣的人工智能具有重要意义,如方向选择性、目标识别、感知处理等。金属氧化物半导体由于其高的载流子迁移率、优异的光学透明性、良好的稳定性以及可大面积制备等优点使其成为人工突触晶体管的潜在候选沟道材料。其中铟锌氧(IZO)和铟镓锌氧(IGZO)是应用最广泛的氧化物材料。Zhu等[11]提出了一种基于磷(P)掺杂纳米颗粒SiO2薄膜质子横向耦合效应的IZO突触晶体管。如图4(a)所示,不需要底部导电,并且栅极电压可以仅通过一个横向双电(EDL)电容直接耦合到IZO半导体实现横向调控。使用该器件模拟了一系列短程可塑性行为,包括两个脉冲时间间隔Δtpre越小可获得较高的PPF数值的双脉冲易化(如图(4b)所示),高频信号越多,突触权重在短时间内增加越多的高通滤波行为(如图4(c)所示)以及时空相关动态逻辑测试(如图4(d))。此外,这种横向耦合的突触晶体管可以很容易扩展到多个输入栅极,以构建突触相互作用的功能。这里提出的这种基于质子传导电解质的横向耦合IZO晶体管对突触电子学和神经形态工程具有重要意义。图4.横向耦合IZO晶体管的突触塑性2019年,He等[23]展示了一种基于金属氧化物铟镓锌氧(IGZO)多端口神经晶体管,模拟了不同时空输入模式的树突辨别,其结构示意图如图5(a)所 示。首先,该器件模拟了突触可塑性的调节行为,如双脉冲易化和高通时间滤波。然后在多端神经晶体管中实现了不同时空输入模式的树突识别,说明它可以作为基本皮层计算的时空信息处理单元,大大减小神经形态系统的规模和复杂性,提高人工神经网络的效率。最后,作为一个时空信息处理的例子,一个有趣的工作——通过基于这种多端IGZO神经晶体管的人工神经网络来模拟人脑的声音定位功能被提出来,利用双耳效应在人脑中定位声音的示意图如图5(b)所示。如图5(c)所示,当声音来自右侧方向时,POSTN1首先处理弱突触传递的信号,然后处理强突触传递的信号。POSTN2首先处理强突触传递的信号,然后处理弱突触传递的信号。因此,在最后一个PREN信号出现时,POSTN1(IPOST1)的突触后电流幅度大于POSTN2(IPOST2)。同样,如果声音是从左方发出的,则IPOST2的振幅大于IPOST1的振幅。最后一个PREN信号时,IPOST和IPOST1的振幅与PREN 2和PREN1峰值(TPREN2-TPREN1)的相对时间和声音方位角的比值如图(5d)所示。最后一个PREN信号时,IPOST1和IPOST2之间的差变随着PREN 1和PREN 2峰值相对时间的变化。当时差为0ms时,比率为1。当时间差在25~1000ms变化时,比值大于1,并且随着时间差的增大而增大。当时间差在-1000~-25ms之间变化时,比值小于1,并且随着时间差的增大而增大。这种与时间相关的识别表明了人工神经网络对声音方位角的检测功能。图5.多端双电层晶体管神经形态模拟有机半导体由于其成本低,化学多功能性强,柔性可弯曲,易于加工等优点被国内外各大实验室所研究,其也被用来制备有机电化学晶体管来模拟突触塑性。2015年,Gkoupidenis等[24]首次报道了使用PEDOT:PSS作为沟道层,KCl 电解质作为栅绝缘层的低功耗有机电化学神经形态晶体管。电解液中的离子由于电场作用会被注入到PEDOT:PSS聚合物中以改变其空穴掺杂水平,从而调节流经通道的空穴电流。当脉冲电压被移除时,由于先前注入的离子会扩散回电解质,PEDOT:PSS将恢复到原来的状态。基于PEDOT:PSS的电化学突触晶体管实现了双脉冲抑制(PPD)和动态滤波特性等典型的突触行为。近年来,Qian等[25]将聚(3-己基噻吩)(P3HT)旋涂在SiO2/Si衬底上作为沟道层,热沉积了金作为源、漏和栅电极,最后将配比的离子凝胶作为栅绝缘层制备了有机电化学晶体管,其结构如图6(a)所示。利用施加在栅极的脉冲电压作为输入刺激,沟道电导变化代表突出权重。该突触晶体管成功模拟了后突触兴奋电流(如图(6b)所示),当施加脉冲栅电压,阴离子从离子凝胶移动到栅绝缘层与沟道层的界面处,从而形成EDL。因此,P3HT中的空穴积聚在半导体和离子凝胶的界面上,导致通道电导增加。在脉冲电压撤去后,阴离子开始扩散,回到它们在离子凝胶中的初始分布,因此PSC恢复到原来的状态。基于P3HT的有机电化学晶体管也实现了自我调整(如图6(c)所示)。当一系列的输入脉冲电压施加时,双脉冲易化出现在前两个尖峰上,但随后EPSC值随着脉冲电压的持续增加而减少,这种现象与生物兴奋性突触的适应性相同。此外,如图6(d)所示该突触晶体管还实现了双栅调控的OR逻辑。图6.有机电化学晶体管的突触塑性模拟光电突触晶体管光电突触晶体管(optoelectronic synaptic transistors)是构成神经形态计算系统的另一基本方法,利用这种新型人工装置模拟突触行为具有高效节能的优势。相对于传统的突触装置需要额外的传感器来进行光电转换。而以光为输入信号的光电神经形态器件,不仅将视觉、信息处理和记忆结合在一起,而且具有带宽高、鲁棒性强、并行性好等优点,适用于模拟人眼视网膜神经元等功能[26-27]。2018年,Yang等[28]制造了基于铟镓锌氧(IGZO)双电层(EDL)晶体管的电阻负载反相器用于光电突触器件应用。这种光电人工突触装置可以模拟突触 行为,如兴奋性突触后电位(EPSP),双脉冲易化(PPF)和长期可塑性等。整个器件可以看作是一种低压光电人工突触。其施加在IGZO通道层上的光脉冲 ,输出电位和沟道的电导改变分别被视为输入信号,突触后电位(PSP)和突触权重,其结构示意图如图7(a)所示。图7(b)的上部和下部分别描绘了不同光脉冲功率(232mw/cm²在和176mw/cm²)在不同栅压下刺激的EPSP曲线。从图中观察到更强的光脉冲信号导致更显著的反应,输出端电位从基态急 剧升高,达到峰值后,突触后电位逐渐回落。在这个过程中,通道电阻被输入光脉冲调制,导致输出电压相应地改变。图7(c)显示了两个连续的突触前光脉 冲触发的EPSP(PPF塑性行为),由第二个突触前光脉冲触发的EPSP的振幅比由第一个突触前光脉冲刺激的EPSP的振幅大1.37倍。图7(d)描述了不同 栅压下,刺激次数累积时,器件突触权重变化情况。图7.基于铟镓锌氧(IGZO)双电层(EDL)晶体管的光电突触塑性同年,Dai等[29]报道了一种有机场效应晶体管的光电突触装置,该装置使用聚丙烯腈(PAN)膜作为介电和电荷捕获层,PAN介质薄膜的强极性官能团可以在沟道/栅介质的界面上产生很强的电荷俘获效应。界面处光生电荷的捕获和去捕获过程为OFET提供了突触行为,如EPSC和PPF。此外,通过调节光刺激参数(包括光脉冲宽度、强度和光脉冲数量),实现了类似于人脑的记忆和学习行为。包括EPSC衰退和遗忘等行为。Wang等[30]报道了一种无机卤化物钙钛矿(CsPbBr3)量子点(QD)的光子突触。将厚度为30nm的CsPbBr3QD层旋涂到100nm厚的SiO2的Si衬底上。超薄的聚甲基丙烯酸甲酯(PMMA)层被旋涂在顶部作为钝化层。然后在PMMA顶部沉积p型并五苯作为半导体沟道。最后通过热蒸发和掩膜版技术沉积金的源、漏电极,该器件结构如图8(a)所示。器件中CsPbBr3量子点和半导体层之间形成的异质结构是该器件的光学可编程和电可擦除特性的基础。在栅极作用下,CsPbBr3量子点中的光生空穴通过能带调控下很容易注入到半导体层,而电子则留在CsPbBr3量子点中。而由于势阱的存在,留在CsPbBr3量子点中电子能保持较长时间从而产生类似突触的记忆效应。想要完全擦除这种记忆效应则需要加一个足够的负栅极电压。利用这种特性,通过光脉冲宽度、光脉冲强度和光脉冲波长等光刺激参数,有效地模拟了EPSC、PPF、PPD等突触塑性,如图(8b)~(d)所示。此报道中光电突触装置的制备有望为今后神经形态器件的设计提供新的思路。图8.有机场效应晶体管的光电突触塑性总结和展望近10年来,在神经形态工程的飞速发展进程中,基于硬件途径实现人造突触得到了充分的重视和研究,从模拟生物突触或神经元行为,到复杂的神经形 态计算 ,都取得了显著的进展。其中三端口晶体管由于具有稳定性好、测试参数相对可控、运行机制清晰、可由多种材料构成等优点在众多被构筑出来用以模拟突触行为的电子器件中脱颖而出。通过适当的材料选择和结构设计,三端/多端突触晶体管可以将外界的刺激(光、压力、温度等)转换成电信号,从而实现对外界环境直接响应的人工突触。此外,三端/多端突触晶体管还具有同时执行信号传输和自学习的优势,而且模拟需要多端操作的并行学习和树突整合可以很容易地在基于三端/多端突触晶体管的人工突触中实现,这为开发具有较少神经元件 的神经网络开辟了可能性。本文讨论了包括铁电突触晶体管、双电层/电化学突触晶体管和光电突触晶体管在内的三端/多端晶体管近年来的最新进展。它们有各自的优缺点,其中铁电场效应晶体管具有编程速度快、无损读出、开关比大、低功耗等优点。然而部分改变铁电材料的极化状态通常需要较大的工作电压,铁电材料的稳定极化状态使其易于实现LTP,但是很难实现STP;双电层/电化学突触晶体管在实现逻辑功能、树突整合和人工树突神经元方面优于其他类型的器件。此外,双电层/电化学晶体管的低压工作特性也为实现超低能耗的突触器件提供了可能。然而,器件的耐用性和电解质的不稳定性可能是双电层/电化学突触晶体管的主要限制;在光电突触晶体管方面,以光为输入信号的光电神经形态器件,不仅将视觉、信息处理和记忆结合在一起,而且具有带宽高、鲁棒性强、并行性好等优点,适用于模拟人眼视网膜神经元等功能。然而,利用光信号实现抑制性突触仍然是一个很大的挑战。这些器件各有优缺点,根据特定应用程序的要求,一种类型的器件可以优先于其他类型的器件。神经形态工程旨在构建具有超低能耗的鲁棒类脑计算机,利用新兴的突触装置来实现人工神经网络已经有了很多成功的尝试,然而神经形态器件领域所面临的一些主要问题和挑战仍需要我们不断进取努力。例如:目前所报道的突触器件模拟的小部分突触行为,完整的人造突触功能还需进一步研究完善;对于能够模拟生物神经元信息处理功能的神经形态器件的研究还仅限于少数报道,迫切需要更 深入的研究;目前科学对人脑的功能和运行机制的了解还在初步阶段。虽然目前这一领域还处于起步阶段,但是在未来,期待利用大量人造突触晶体管模拟类似于感官(视觉、听觉、运动、嗅觉)这样复杂的人类神经系统。相信通过物理、化学、材料学、计算机和医学等科学领域的跨学科交流,类脑神经形态工程将获得不断的革新进步和应用,先进的人工智能系统将促进人类在服务行业、个人医疗、教育和交通等领域的生活。文献引用:朱力,万青. 神经形态晶体管研究进展[J]. 微纳电子与智能制造, 2019, 1(4): 39-50.Research progress of neuromorphic transistors[J]. Micro/nano Electronics and Intelligent Manufacturing, 2019, 1(4): 39-50.《微纳电子与智能制造》刊号:CN10-1594/TN主管单位:北京电子控股有限责任公司主办单位:北京市电子科技科技情报研究所北京方略信息科技有限公司投稿邮箱:tougao@mneim.org.cn(网站:www.mneim.org.cn)参考文献:[1] BACKUS J. Can programming be liberated from the von Neumann style? a function style and its algebra of programs[J]. Communications of the ACM, 1978, 21(8): 613-641. [2] DRACHMAN D A. Do wo have brain to spare[J]. Neurology, 2005, 64 (12):2004-2005. [3] FURBER S. To build a brain[J]. Spectrum IEEE, 2012, 49(8): 44-49. [4]MARKRAM H. The blue brain project[J]. Nature Reviews Neuroscience, 2006, 7(2): 153-160.[5] MARKRAM H, GERSTNER W, SJÖSTRÖM P J. A history of spike-timing-dependent plasticity[J]. Frontiers in Synaptic Neuroscience, 2011, 3(4): 4. [6] CAPORALE N, DAN Y. Spike timing-dependent plasticity: a hebbian learning rule[J]. Annual Review of Neuroscience, 2008, 31(1): 25-46. [7] RACHMUTH G, SHOUVAL H Z, BEAR M F, et al. A biophysically- based neuromorphic model of spike rate- and timing-dependent plasticity[J]. Proceedings of the National Academy of Sciences, 2011, 108(49): E1266-74. [8] PREZIOSO M, MERRIKH-BAYAT F, HOSKINS B D, et al. Training and operaion of an integrated neuromorphic network based on metal- oxide memeristors[J]. Nature, 2015, 521(7550): 61-64. [9 ] XU W, LEE Y, MIN S Y, et al. Simple, inexpensive, and rapid approch to fabricate cross- shaped memristors using an inorganic- nanowire- alignment technique and a one- step reduction process[J]. Advanced Materials, 2016, 28(3): 527-532. [10] NISHITANI Y, KANEKO Y, UEDA M, et al. Three-terminal ferroelectric synapse device with concurrent learning function for artficial neural networks[J]. Journal of Applied Physics, 2012, 111(12): 124108-1-124108-6. [11] ZHU L Q, WAN C J, GUO L Q, et al. Artificial synapse network on inorganic proton conductor for neuromorphic systems[J]. Nature Communications, 2014, 5: 3158. [12] DAI S, WU X, LIU D, et al. Light- stimulated synaptic devices utilizing interfacial effect of organic field-effect transistors[J]. ACS Applied Materials & Interfaces, 2018, 10 (25): 21472-21480. [13] WANG K, DAI S, ZHAO Y, et al. Light-stimulated synaptic transistors fabricated by a facile solution process based on inorganic perovskite quantum dots and organic semiconductors[J]. Small, 2019, 15(11): 1900010-1-19000010-8. [14] MILLER S L, MCWHORTER P J. Physics of the ferroelectric nonvolatile memory field effect transistor[J]. Journal of Applied Physics, 1992, 72(12): 5999-6010. [15] KANEKO Y, NISHITANI Y, UEDA M. Ferroelectric artificial synapases for recognition of a multishaded image [J]. IEEE Transactions on Electron Devices, 2014, 61 (8): 2827-2833. [16] KIM M K, LEE J S. Ferroelectric analog synaptic transistors[J]. Nano Letters, 2019, 19(3): 2044-2050. [17] JANG S, JANG S, LEE E -H, et al. Ultrathin comformable organic artificial synapses for wearable intelligent device applicatios[J]. ACS Applied Materials & Interfaces, 2019, 11(1): 1071-1080. [18] MIN Y, AKBULULUT M, SANGORO J R, et al. Measurement of forces across room temperature ionic liquids between mica surfaces[J]. The Journal of Physical Chemistry C, 2009, 113(37): 16445-16449. [19] KIM S H, HONG K, XIE W, et al. Electrolyte-gated transistors for organic and printed electronics[J]. Advanced Materials, 2013, 25(13): 1822-1846. [20] KIM K, CHEN C L, TRUONG Q, et al. A carbon nanotube synapse with dynamic logic and learning[J]. Advanced Materials, 2013, 25(12): 1693-1698. [21] SHARBATI M T, DU Y, TORRES J, et al. Low- power, electrochemically tunable graphene synapses for neuromorphic computing[J]. Advanced Materials, 2018, 30 (36): 1802353. [22] JIANG J, GUO J, WAN X, et al. 2D MoS2 neuromorphic devices for brain- like computational systems[J]. Small, 2017, 13(29): 1900933-1-1700933-11. [23] HE Y L, NIE S, LIU R, et al. Spatiotemporal information processing emulated by multiterminal neuro- transistor networks[J]. Advanced Materials, 2019, 31(21): 1900903-1-19000903-8. [24] GKOUPIDENIS P, SCHAEFER N, GARLAN B, et al. Neuromorphic functions in PEDOT: PSS organic electrochemical transistors[J]. Advanced Materials, 2015, 27 (44): 7176-7180. [25] QIAN C, SUN J, KONG L A, et al. Artificial synapses based on in- plane gate organic electrochemical transistors[J]. ACS Applied Materials & Interfaces, 2016, 8 (39): 26169-26175. [26] KURAMOCHI E, NOZAKI K, SHINYA A, et al. Largescale integration of wavelength- addressable all- optical memories on a photonic crystal chip[J]. Nature Photonics, 2014, 8(6): 474-481. [27] GHOLIPOUR B, BASTOCK P, CRAIG C, et al. Amorphous metal- sulphide microfibers enable photonic synapses for brain-like computing[J]. Advanced Optical Materials, 2015, 3(5): 635-641. [28] LI H K, CHEN T P, LIU P, et al. A light-stimulated synaptic transistor with synaptic plasticity and memory functions based on InGaZnOx- Al2O3 thin film structure [J]. Journal of Applied Physics, 2016, 119(24): 244505- 1-244505-5. [29] DAI S L,WU X H, LIU D P, et al. Light-stimulated synaptic devices utilizing interfacial effect of organic fieldeffect transistors[J]. Applied Materials & Interfaces, 2018, 10(25): 21472-21480. [30] WANG Y, LV Z Y, CHEN J R, et al. Photonic synapses based on inorganic perovskite quantum dots for neuromorphic computing[J]. Advanced Materials, 2018, 30 (38): 1802883-1-1802883-9.来自微信 -

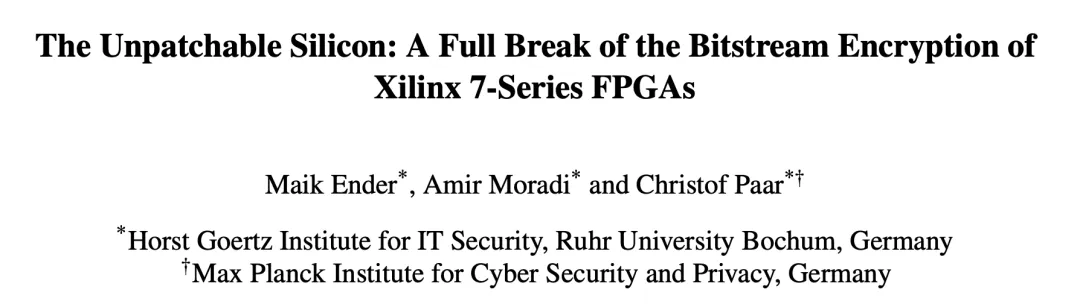

FPGA惊天大漏洞细节全解读 来源:内容授权转载自公众号「老石谈芯」,作者:老石,谢谢。今年4月,来自德国的研究者披露了一个名为“StarBleed”的漏洞,它存在于赛灵思的Virtex、Kintex、Artix、Spartan 等全部7系列FPGA中。通过这个漏洞,攻击者可以同时攻破FPGA配置文件的加密(confidentiality)和鉴权(authenticity),并由此可以随意修改FPGA中实现的逻辑功能。更严重的是,这个漏洞并不能通过软件补丁的方式修复,一旦某个芯片被攻破,就只能通过更换芯片的方式修复。漏洞的发现者已于2019年9月将这个漏洞知会了赛灵思,并在第二天就获得了赛灵思的承认。根据赛灵思之前发布的财报,7系列FPGA贡献了公司35%的营收。这些FPGA被广泛用于通信设备、医疗、军工宇航等多个领域,而这些领域很多都需要系统有着很高的稳定性与安全性。因此,这次爆出的重大漏洞,无疑会对赛灵思及其客户带来较大的负面影响。近年来,有关CPU的漏洞时有发现。例如在2018年初,几乎全部主流的CPU厂商都被发现在其CPU产品中存在熔断(Meltdown)和幽灵(Spectre)漏洞。相比之下,FPGA的漏洞问题并不那么“常见”。在这篇文章中,老石将深入解析造成这个漏洞的技术原因,并总结一些可行的应对方法与预防措施。FPGA的主要加密方式随着FPGA在数据中心、通信基础设施、AI加速、医疗设备、边缘计算等多个领域的广泛使用,针对FPGA安全性的研究在近年来逐渐成为学术界和工业界关注的热点之一。与CPU、ASIC等芯片相比,FPGA芯片本身并不会完成任何逻辑功能,它只包含大量的可编程逻辑阵列,以及若干固化的IP核。FPGA系统功能的实现,基本完全取决于开发者的逻辑设计。由于不同的设计者可以开发不同的系统逻辑,这就使得相同的FPGA芯片可以广泛用于众多不同的行业领域。通常来说,一个FPGA设计都是由很多IP组合而成,而这些IP才是FPGA设计中最有价值的部分。为了将设计加载到FPGA中运行,唯一的方式就是通过一个所谓的“比特流(bitstream)”文件完成,业界也通常称之为系统映像。系统映像由FPGA设计软件自动生成,它包含了FPGA设计的全部信息,因此是FPGA加密环节的重中之重。通常来说,对比特流或系统映像文件的保护方式有两个层面,第一是加密,第二是鉴权。加密指的是使用特定算法对比特流文件进行处理,将其转换成密文,使得其中的内容对外不可见。在赛灵思的7系列FPGA中,使用了CBC-AES-256算法进行比特流加密。鉴权指的是对加密后的比特流文件进行身份验证,防止对其进行篡改和删减,这类似于我们日常生活中的身份验证。如果比特流文件被修改,势必会导致错误的鉴权结果。如果将这个比特流下载到FPGA中,会因为身份校验失败而拒绝执行,从而避免被攻击的可能。在赛灵思的7系列FPGA中,使用了基于SHA-256的HMAC(散列消息认证码,Hash-based Message Authentication Code)方法进行鉴权。可以想象,如果比特流的加密过程被破解,那么攻击者就可以读出比特流文件中的所有信息,从而进行反向工程、IP破解、信息收集等工作。如果鉴权过程被破解,那么攻击者就可以对比特流文件进行任意修改,比如修改系统功能、木马注入等。所以说,这两种保护方式缺一不可。只可惜,这次的StarBleed漏洞恰恰利用了这两种保护方式各自的短板,从而彻底破解比特流的加密和鉴权,并达到了完全控制比特流和FPGA芯片的目的,可以说这个漏洞的破坏性和潜在危害性极强。StarBleed漏洞的具体攻击方法整个攻击过程分为两大部分,第一是对加密的比特流文件进行破解,第二是获取鉴权密钥。为了破解加密的比特流文件,攻击者利用了赛灵思FPGA里的一个特殊的配置寄存器WBSTAR,这个寄存器原本保存了FPGA MultiBoot功能的起始地址,当启动FPGA时,就通过读取这个寄存器从片外非易失性存储器找到映像文件。因此,当FPGA复位时,这个寄存器的内容是不会被抹掉的。对加密比特流的破解过程分为5个步骤。第一步,攻击者对一个合法的比特流文件进行了简单篡改。具体来说,他需要修改比特流的一个32位字,将其改成对WBSTAR寄存器的写操作。写入的内容,就是比特流本身。虽然比特流是加密的,但这个篡改过程并没有想象中那么困难。由于Vivado生成的比特流文件的格式和很多内容是固定的,攻击者可以对比不同的比特流文件,从而确定对WBSTAR寄存器操作命令的位置,然后对其进行修改即可。由于篇幅所限,这部分的具体的细节不再赘述,欢迎在知识星球或微博与老石进一步交流。比特流数据结构,灰色部分是加密的内容第二步,将篡改后的比特流加载到FPGA里。此时,FPGA会对比特流进行解密,并将一个32位字写入WBSTAR寄存器。值得注意的是,这里写入的是已经解密的比特流内容!第三步,加载完毕后,由于比特流发生了修改,因此校验失败,并自动触发系统复位。第四步,使用另外一个未加密的比特流文件,读取WBSTAR寄存器的内容。由于WBSTAR寄存器的特殊性,它的内容不会随着复位而清除。因此,此时攻击者再使用另外一个未加密的比特流文件读取这个寄存器的内容,就可以得到解密后的FPGA比特流的32位内容了。这个未加密的比特流文件已开源,请在文末扫码进入知识星球查看。第五步,手工复位,然后重复上述步骤,直到整个比特流都解密完成。可以看到,攻击者利用了上面提到的鉴权过程晚于加解密过程这个缺陷,通过“蚂蚁搬家”的方式完成了对比特流的完全解密。最可怜的是,此时的FPGA本身也沦为了帮助解密的工具。这也解释了为什么只能通过更换FPGA芯片才能修补这个漏洞。下面的表格总结了不同的7系列FPGA的比特流大小,以及解密所需要的时间。读出一个32位字大概需要7.9毫秒,那么破解一个Kintex FPGA的比特流就大概需要3小时42分钟。接下来,就可以对鉴权过程进行破解了。这个过程相对简单,事实上,身份校验所需的HMAC密钥就存储在比特流文件中,并且未经其他额外的加密。这正是所谓的“谜底就在谜面上”。所以只需要读取完整的比特流,就可以免费附赠HMAC密钥一枚。有了它,就可以任意修改比特流文件的内容,并重新计算身份校验。此外,攻击者甚至可以修改HMAC密钥本身。综上所述,StarBleed漏洞正是利用了赛灵思7系列FPGA的两大设计缺陷:身份校验发生在解密过程之后身份校验的密钥直接存储在加密后的比特流文件里,且无额外加密通过StarBleed漏洞,攻击者破解了全系列的赛灵思7系FPGA,包括SAKURA-X板卡上的Kintex-7,Basys3板卡上的Artix-7等等。同时,攻击者还利用同样的原理攻击了6系FPGA,例如ML605板卡上的Virtex-6 FPGA,也能实现不完全破解。防御方法由于StarBleed漏洞直接利用了赛灵思7系列FPGA芯片的设计缺陷,且攻击过程直接在加载映像文件时展开,因此不能使用软件补丁或固件升级的方法规避这个漏洞。目前唯一的修复方法只有更换芯片,赛灵思官方已经向研究者承认了这一点。事实上,攻击者使用这种方法无法破解UltraScale或更新的FPGA系列。这说明上面所说的设计缺陷已经在新型FPGA架构中得到了修复。例如,首先对比特流文件进行鉴权,通过后再进行加载。虽然除了换芯片外没有完全防御的方法,我们仍然可以采用一些设计手段增加破解的成本和复杂度。一个常见的方法是在设计中增加额外的冗余逻辑,这些额外的部分并不影响逻辑功能,但会极大的提升设计的复杂度,从而增加破解的时间成本。比如,在状态机中增加很多无用状态等等。此外,还可以在板卡设计时封锁FPGA的配置端口,比如研究者使用的JTAG和SelectMAP端口等。事实上,在量产的FPGA设计中,应该也很少有暴露的JTAG端口。同时,研究者还思考了如何尽早发现这类设计缺陷和漏洞,而形式化方法就是一个很好的解决手段。设计者可以根据芯片的设计规约,建立形式化模型,并通过满足性验证(satisfiability)等方式对这个模型进行分析和证明。结语FPGA的安全性研究并非一个全新的课题。然而,传统的FPGA攻击方法都需要使用额外的物理设备或操作,实用性远不如此次爆出的StarBleed漏洞。一旦FPGA被攻破,攻击者可以任意读取FPGA比特流的数据、IP内容等,并实现反向工程;也可以任意改变FPGA实现的逻辑功能,这使得FPGA所在的系统可能沦为攻击者的高性能“肉鸡”。由于FPGA能以40Gbps甚至更高的速度线速发送数据包,这使得大规模DDOS攻击变得“简单”。此外,攻击者也可以通过逻辑实现的方式,大幅提升芯片温度并对系统硬件进行不可逆的物理破坏,等等。可以说,这次的StarBleed漏洞给业界敲响了警钟,也将会提升人们对FPGA安全性的重视,并以此指导未来的FPGA安全性设计。亡羊补牢,犹未晚也。(注:本文仅代表作者个人观点,与任职单位无关。)*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。今天是《半导体行业观察》为您分享的第2289期内容,欢迎关注。来自微信

FPGA惊天大漏洞细节全解读 来源:内容授权转载自公众号「老石谈芯」,作者:老石,谢谢。今年4月,来自德国的研究者披露了一个名为“StarBleed”的漏洞,它存在于赛灵思的Virtex、Kintex、Artix、Spartan 等全部7系列FPGA中。通过这个漏洞,攻击者可以同时攻破FPGA配置文件的加密(confidentiality)和鉴权(authenticity),并由此可以随意修改FPGA中实现的逻辑功能。更严重的是,这个漏洞并不能通过软件补丁的方式修复,一旦某个芯片被攻破,就只能通过更换芯片的方式修复。漏洞的发现者已于2019年9月将这个漏洞知会了赛灵思,并在第二天就获得了赛灵思的承认。根据赛灵思之前发布的财报,7系列FPGA贡献了公司35%的营收。这些FPGA被广泛用于通信设备、医疗、军工宇航等多个领域,而这些领域很多都需要系统有着很高的稳定性与安全性。因此,这次爆出的重大漏洞,无疑会对赛灵思及其客户带来较大的负面影响。近年来,有关CPU的漏洞时有发现。例如在2018年初,几乎全部主流的CPU厂商都被发现在其CPU产品中存在熔断(Meltdown)和幽灵(Spectre)漏洞。相比之下,FPGA的漏洞问题并不那么“常见”。在这篇文章中,老石将深入解析造成这个漏洞的技术原因,并总结一些可行的应对方法与预防措施。FPGA的主要加密方式随着FPGA在数据中心、通信基础设施、AI加速、医疗设备、边缘计算等多个领域的广泛使用,针对FPGA安全性的研究在近年来逐渐成为学术界和工业界关注的热点之一。与CPU、ASIC等芯片相比,FPGA芯片本身并不会完成任何逻辑功能,它只包含大量的可编程逻辑阵列,以及若干固化的IP核。FPGA系统功能的实现,基本完全取决于开发者的逻辑设计。由于不同的设计者可以开发不同的系统逻辑,这就使得相同的FPGA芯片可以广泛用于众多不同的行业领域。通常来说,一个FPGA设计都是由很多IP组合而成,而这些IP才是FPGA设计中最有价值的部分。为了将设计加载到FPGA中运行,唯一的方式就是通过一个所谓的“比特流(bitstream)”文件完成,业界也通常称之为系统映像。系统映像由FPGA设计软件自动生成,它包含了FPGA设计的全部信息,因此是FPGA加密环节的重中之重。通常来说,对比特流或系统映像文件的保护方式有两个层面,第一是加密,第二是鉴权。加密指的是使用特定算法对比特流文件进行处理,将其转换成密文,使得其中的内容对外不可见。在赛灵思的7系列FPGA中,使用了CBC-AES-256算法进行比特流加密。鉴权指的是对加密后的比特流文件进行身份验证,防止对其进行篡改和删减,这类似于我们日常生活中的身份验证。如果比特流文件被修改,势必会导致错误的鉴权结果。如果将这个比特流下载到FPGA中,会因为身份校验失败而拒绝执行,从而避免被攻击的可能。在赛灵思的7系列FPGA中,使用了基于SHA-256的HMAC(散列消息认证码,Hash-based Message Authentication Code)方法进行鉴权。可以想象,如果比特流的加密过程被破解,那么攻击者就可以读出比特流文件中的所有信息,从而进行反向工程、IP破解、信息收集等工作。如果鉴权过程被破解,那么攻击者就可以对比特流文件进行任意修改,比如修改系统功能、木马注入等。所以说,这两种保护方式缺一不可。只可惜,这次的StarBleed漏洞恰恰利用了这两种保护方式各自的短板,从而彻底破解比特流的加密和鉴权,并达到了完全控制比特流和FPGA芯片的目的,可以说这个漏洞的破坏性和潜在危害性极强。StarBleed漏洞的具体攻击方法整个攻击过程分为两大部分,第一是对加密的比特流文件进行破解,第二是获取鉴权密钥。为了破解加密的比特流文件,攻击者利用了赛灵思FPGA里的一个特殊的配置寄存器WBSTAR,这个寄存器原本保存了FPGA MultiBoot功能的起始地址,当启动FPGA时,就通过读取这个寄存器从片外非易失性存储器找到映像文件。因此,当FPGA复位时,这个寄存器的内容是不会被抹掉的。对加密比特流的破解过程分为5个步骤。第一步,攻击者对一个合法的比特流文件进行了简单篡改。具体来说,他需要修改比特流的一个32位字,将其改成对WBSTAR寄存器的写操作。写入的内容,就是比特流本身。虽然比特流是加密的,但这个篡改过程并没有想象中那么困难。由于Vivado生成的比特流文件的格式和很多内容是固定的,攻击者可以对比不同的比特流文件,从而确定对WBSTAR寄存器操作命令的位置,然后对其进行修改即可。由于篇幅所限,这部分的具体的细节不再赘述,欢迎在知识星球或微博与老石进一步交流。比特流数据结构,灰色部分是加密的内容第二步,将篡改后的比特流加载到FPGA里。此时,FPGA会对比特流进行解密,并将一个32位字写入WBSTAR寄存器。值得注意的是,这里写入的是已经解密的比特流内容!第三步,加载完毕后,由于比特流发生了修改,因此校验失败,并自动触发系统复位。第四步,使用另外一个未加密的比特流文件,读取WBSTAR寄存器的内容。由于WBSTAR寄存器的特殊性,它的内容不会随着复位而清除。因此,此时攻击者再使用另外一个未加密的比特流文件读取这个寄存器的内容,就可以得到解密后的FPGA比特流的32位内容了。这个未加密的比特流文件已开源,请在文末扫码进入知识星球查看。第五步,手工复位,然后重复上述步骤,直到整个比特流都解密完成。可以看到,攻击者利用了上面提到的鉴权过程晚于加解密过程这个缺陷,通过“蚂蚁搬家”的方式完成了对比特流的完全解密。最可怜的是,此时的FPGA本身也沦为了帮助解密的工具。这也解释了为什么只能通过更换FPGA芯片才能修补这个漏洞。下面的表格总结了不同的7系列FPGA的比特流大小,以及解密所需要的时间。读出一个32位字大概需要7.9毫秒,那么破解一个Kintex FPGA的比特流就大概需要3小时42分钟。接下来,就可以对鉴权过程进行破解了。这个过程相对简单,事实上,身份校验所需的HMAC密钥就存储在比特流文件中,并且未经其他额外的加密。这正是所谓的“谜底就在谜面上”。所以只需要读取完整的比特流,就可以免费附赠HMAC密钥一枚。有了它,就可以任意修改比特流文件的内容,并重新计算身份校验。此外,攻击者甚至可以修改HMAC密钥本身。综上所述,StarBleed漏洞正是利用了赛灵思7系列FPGA的两大设计缺陷:身份校验发生在解密过程之后身份校验的密钥直接存储在加密后的比特流文件里,且无额外加密通过StarBleed漏洞,攻击者破解了全系列的赛灵思7系FPGA,包括SAKURA-X板卡上的Kintex-7,Basys3板卡上的Artix-7等等。同时,攻击者还利用同样的原理攻击了6系FPGA,例如ML605板卡上的Virtex-6 FPGA,也能实现不完全破解。防御方法由于StarBleed漏洞直接利用了赛灵思7系列FPGA芯片的设计缺陷,且攻击过程直接在加载映像文件时展开,因此不能使用软件补丁或固件升级的方法规避这个漏洞。目前唯一的修复方法只有更换芯片,赛灵思官方已经向研究者承认了这一点。事实上,攻击者使用这种方法无法破解UltraScale或更新的FPGA系列。这说明上面所说的设计缺陷已经在新型FPGA架构中得到了修复。例如,首先对比特流文件进行鉴权,通过后再进行加载。虽然除了换芯片外没有完全防御的方法,我们仍然可以采用一些设计手段增加破解的成本和复杂度。一个常见的方法是在设计中增加额外的冗余逻辑,这些额外的部分并不影响逻辑功能,但会极大的提升设计的复杂度,从而增加破解的时间成本。比如,在状态机中增加很多无用状态等等。此外,还可以在板卡设计时封锁FPGA的配置端口,比如研究者使用的JTAG和SelectMAP端口等。事实上,在量产的FPGA设计中,应该也很少有暴露的JTAG端口。同时,研究者还思考了如何尽早发现这类设计缺陷和漏洞,而形式化方法就是一个很好的解决手段。设计者可以根据芯片的设计规约,建立形式化模型,并通过满足性验证(satisfiability)等方式对这个模型进行分析和证明。结语FPGA的安全性研究并非一个全新的课题。然而,传统的FPGA攻击方法都需要使用额外的物理设备或操作,实用性远不如此次爆出的StarBleed漏洞。一旦FPGA被攻破,攻击者可以任意读取FPGA比特流的数据、IP内容等,并实现反向工程;也可以任意改变FPGA实现的逻辑功能,这使得FPGA所在的系统可能沦为攻击者的高性能“肉鸡”。由于FPGA能以40Gbps甚至更高的速度线速发送数据包,这使得大规模DDOS攻击变得“简单”。此外,攻击者也可以通过逻辑实现的方式,大幅提升芯片温度并对系统硬件进行不可逆的物理破坏,等等。可以说,这次的StarBleed漏洞给业界敲响了警钟,也将会提升人们对FPGA安全性的重视,并以此指导未来的FPGA安全性设计。亡羊补牢,犹未晚也。(注:本文仅代表作者个人观点,与任职单位无关。)*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。今天是《半导体行业观察》为您分享的第2289期内容,欢迎关注。来自微信 -

关于量子通信与量子计算,终于有人讲透了! EET0P2018年09月17日11:59来源:绿盟博客 作者:陈磊 原地址:http://blog.nsfocus.net/quantum-information-technology/本文首先介绍量子相关的基本概念、性质及基本原理;接着,从量子通信和量子计算两个部分阐述其原理与发展现状;然后,简单介绍了后量子密码学(也称抗量子密码体制)的发展情况;最后,对量子信息技术的发展进行总结与展望。文章目录1 引言2 量子信息简介2.1 量子概念2.2 量子基本特性2.3 量子信息2.4 量子信息学3 量子通信3.1 量子通信系统基本模型3.2 量子通信技术优势3.3 量子密钥分配基本原理3.4 量子隐形传态基本原理3.5 理论与试验研究进展3.6 产业化进展与面临的挑战4 量子计算4.1 典型量子算法4.2 量子机器学习与深度学习算法4.3 量子计算机4.4 量子编码5 后量子密码6 总结1 引言量子信息科学(Quantum Information)是以量子力学为基础,把量子系统“状态”所带有的物理信息,进行信息编码、计算和传输的全新信息技术。量子信息技术主要包括量子通信和量子计算,由于它们具有潜在的应用价值和重大的科学意义,正引起人们广泛的关注和研究。本文首先介绍量子相关的基本概念、性质及基本原理;接着,从量子通信和量子计算两个部分阐述其原理与发展现状;然后,简单介绍了后量子密码学(也称抗量子密码体制)的发展情况;最后,对量子信息技术的发展进行总结与展望。2 量子信息简介在本章中,首先介绍量子和量子信息基本概念及相关特性;然后介绍量子信息学领域的研究分支及其研究内容。2.1 量子概念量子(Quantum)属于一个微观的物理概念。如果一个物理量存在最小的不可分割的基本单位[1],那么称这个物理量是可量子化的,并把物理量的基本单位称为量子。现代物理中,将微观世界中所有的不可分割的微观粒子(光子、电子、原子等)或其状态等物理量统称为量子。量子这个概念最早由德国物理学家普朗克在1900年提出的,他假设黑体辐射中的辐射能量是不连续的,只能取能量基本单位的整数倍,这很好地解释了黑体辐射的实验现象。即假设对于一定频率的电磁辐射,物体只以“量子”的方式吸收和发射,每个“量子”的能量可以表示为:,为普朗克常数。量子假设的提出有力地冲击了牛顿力学为代表的经典物理学,促进物理学进入微观层面,奠定了现代物理学基础,进入了全新的领域。2.2 量子基本特性作为一种微观粒子,量子具有许多特别的基本特性,如量子力学三大基本原理:量子测不准也称为不确定性原理,即观察者不可能同时知道一个粒子的位置和它的速度,粒子位置的总是以一定的概率存在某一个不同的地方,而对未知状态系统的每一次测量都必将改变系统原来的状态。也就是说,测量后的微粒相比于测量之前,必然会产生变化。量子不可克隆量子不可克隆原理,即一个未知的量子态不能被完全地克隆。在量子力学中,不存在这样一个物理过程:实现对一个未知量子态的精确复制,使得每个复制态与初始量子态完全相同。量子不可区分量子不可区分原理,即不可能同时精确测量两个非正交量子态。事实上,由于非正交量子态具有不可区分性,无论采用任何测量方法,测量结果的都会有错误。除此之外,还包括以下基本特性:量子态叠加性(superposition)量子状态可以叠加,因此量子信息也是可以叠加的。这是量子计算中的可以实现并行性的重要基础,即可以同时输入和操作个量子比特的叠加态。量子态纠缠性(entanglement)两个及以上的量子在特定的(温度、磁场)环境下可以处于较稳定的量子纠缠状态,基于这种纠缠,某个粒子的作用将会瞬时地影响另一个粒子。爱因斯坦称其为: “幽灵般的超距作用”。量子态相干性(interference)量子力学中微观粒子间的相互叠加作用能产生类似经典力学中光的干涉现象。2.3 量子信息一个经典的二进制存储器只能存一个数:要么存 0,要么存 1。但一个二进制量子存储器却可以同时存储0和1这两个数。两个经典二进制存储器只能存储以下四个数的一个数: 00,01,10 或 11。倘若使用两个二进制量子存储器,则以上四个数可以同时被存储下来。按此规律,推广到N个二进制存储器的情况,理论上,N个量子存储器与N个经典存储器分别能够存储个数和1个数。由此可见,量子存储器的存储能力是呈指数增长的,它比经典存储器具有更强大的存储数据的能力,尤其是当 N很大时(如 N=250 ),量子存储器能够存储的数据量比宇宙中所有原子的数目还要多[1]。2.4 量子信息学量子信息学是量子力学与信息科学形成的一个交叉学科,该领域主要包括两个领域:量子通信和量子计算。其中量子通信主要研究的是量子介质的信息传递功能进行通信的一种技术,而量子计算则主要研究量子计算机和适合于量子计算机的量子算法。图 1 量子信息学的研究分支3 量子通信所谓量子通信,从概念角度来讲就是利用量子介质的信息传递功能进行通信的一种技术。它主要包括量子密钥分配、量子隐形传态等技术。量子密码 (Quantum Cryptography)是利用量子力学属性开发的密码系统。与传统的密码系统不同的是,它的安全性依赖于量子力学属性(不可测量和不可克隆等)而不是数学的复杂度理论。量子密钥分配是研究最为成熟的量子密码技术。在本章中,我们首先简单地介绍量子通信系统的基本模型以及优势,然后介绍量子密钥分配和量子隐形传态的基本原理。接着,概述量子通信的目前研究与发展现状。最后,总结量子通信目前存在的问题。3.1 量子通信系统基本模型量子通信体系架构包括量子态发生器、量子通道和量子测量装置以及经典信道等部分,其基本模型如图2所示。图 2 量子通信系统基本模型量子通信过程可以从发送端和接收端两个角度理解。在发送端,量子信源模块产生消息,消息通过量子编码模块转换成量子比特,量子比特通过量子调制模块得到以量子态为载体的量子信息,量子信息通过量子信道进行传输。除此以外,量子调制的模式信息(传统的信息)需要使用经典信道进行传输。在接收端,将接收到两部分信息:量子信道接收量子信息;经典信道接收额外的经典信息。这两部分信息通过解调和解码模块后,获得最终的消息。3.2 量子通信技术优势量子通信与传统通信技术相比,具有如下主要特点和优势:(1) 时效性高。量子通信的线路时延近乎为零,量子信道的信息效率相对于经典信道量子的信息效率高几十倍,传输速度快。(2) 抗干扰性能强。量子通信中的信息传输不通过传统信道(如传统移动通信为了使得通信不被干扰,需要约定好频率,而量子通信不需要考虑这些因素),与通信双方之间的传播媒介无关,不受空间环境的影响,具有完好的抗干扰性能。(3) 保密性能好。根据量子不可克隆定理,量子信息一经检测就会产生不可还原的改变,如果量子信息在传输中途被窃取,接收者必定能发现。(4) 隐蔽性能好。量子通信没有电磁辐射,第三方无法进行无线监听或探测。(5) 应用广泛。量子通信与传播媒介无关,传输不会被任何障碍阻隔,量子隐形传态通信还能穿越大气层。因此,量子通信应用广泛,既可在太空中通信,又可在海底通信,还可在光纤等介质中通信。3.3 量子密钥分配基本原理量子密钥分配 (Quantum Key Distribution, QKD)以量子态为信息载体,通过量子信道使通信收发双方共享密钥,是密码学与量子力学相结合的产物。QKD 技术在通信中并不传输密文,而是利用量子信道将密钥分配给通信双方,由于量子力学的测不准和量子不可克隆定理,攻击者无法获取正确的密钥。基于QKD 技术的保密通信系统结构如图3所示,其中上路负责密钥分配,下路负责传输加解密数据。在上路中,量子信道负责传输量子密钥,经典信道负责传输测量基[2]等额外需要的信息。下面,将以BB84[5]方案为例,具体地介绍两条信道起到的作用。图 3 基于QKD 的量子保密通信系统BB84 方案。1984 年,Brassard与Bennett联合提出了第一个实用型量子密钥分配系统—BB84 方案,系统架构如图4 所示。图 4 BB84协议示意图[20]该方案通过量子信道传送密钥,量子信道的信息载体是单个量子,通过量子的相位、极化方向或频率等物理量携带量子密钥信息。BB84 方案利用单个量子作为信息载体两组共扼基,每组基中的两个极化互相正交。由于理想状态的量子信道无法实现,BB84 方案还利用经典信道进行量子态测量方法的协商和码序列的验证。有趣的现象:接收端必须使用正确的测量基,才能正确地测出量子比特(光量子的偏振态);使用错误的测量基,测量结果将发生错误,同时光量子的偏振态发生改变,如图5所示。图 5测量基对测量结果的影响[20]有了以上基础后,理解BB84协议将变得相对容易,其主要步骤如下:量子信道部分(1) Alice发送随机的量子比特串给Bob。Alice随机选择四种偏振片,制备不同偏振状态的光量子,得到足够多的随机量子比特并将其发送给Bob。(2) Bob随机选择测量基测量量子比特。由于Bob并不知道光量子是由发送端那一种测量基编码的,所以他也只能随机选择测量基来进行测量。当选择正确的测量基时,测量的结果正确。当使用错误的测量结果时,测量结果错误。经典信道部分(3) Bob将使用的测量基发送给Alice。(4) Alice将接收的测量基与使用的测量基进行比较,并通过信息告诉Bob哪些位置的测量基是正确的。(5) Bob根据Alice的消息剔除错误的量子比特,并将选择少部分正确的测量结果告诉Alice。(6) Alice确认Bob测量结果的正确性。若错误,则说明存在量子信道可能存在窃听,停止通信或者返回第 (1) 步(由于实际的量子信道中也存在噪声,因此会根据一个错误率阈值判断是否窃听和停止通信)。若正确,剔除部分的量子比特,剩下的二进制串作为最终的密钥。并发送确认信息给Bob。(7) Bob收到确认信息。同样剔除部分的量子比特,剩下的二进制串作为最终的密钥。我们对BB84协议的安全性做一个简单的分析:如果Eve在量子信道中旁路窃听,由于量子不可克隆,因此Eve无法复制出一份相同的量子比特副本;如果他在量子信道中直接测量光量子,由于Eve不知正确的测量基,他也会随机选择,有50%的概率选择正确,50%的概率选择错误。若选择的测量基错误,有上述的有趣的现象可知,测量结果错误,同时光量子的偏振态发生改变。当协议的步骤由 (2) 执行到 (6) 时,Alice将发现到量子信道的窃听,那么她将终止这一过程。如果在经典信道进行窃听呢?实际上也是无效的。即使Eve知道了测量基信息(步骤 (3)),然而由于量子不可克隆,无法得到正确的量子比特串副本。由以上分析可知,BB84协议基于量子不可克隆等原理,实现安全的密钥分配过程。3.4 量子隐形传态基本原理量子隐形传态( Quantum Teleportation) 又称量子远程传态或量子离物传态,是利用量子纠缠的不确定特性,将某个量子的未知量子态通过EPR对(纠缠量子对)的一个量子传送到另一个地方(即EPR对中另一个量子),而原来的量子仍留在原处。如图所示6所示,Alice想和Bob通信,具体流程如下:(1) 制备两个有纠缠的EPR量子(粒子)对,然后将其分开,Alice和Bob各持一个,分别是粒子1和粒子2。(2) Alice粒子1和某一个未知量子态的粒子3进行联合测量,然后将测量结果通过经典信道传送给接Bob。此时,神奇的事情发生了:Bob持有的粒子2将随着Alice测量同时发生改变,由一量子态变成新的量子态。这是由于量子纠缠的作用,粒子2和粒子1之间如同有一根无形。(3) Bob根据接收的息和拥有粒子2做相应幺正变换(一种量子计算变换),根据这些信息,可以重构出粒子3的全貌。图 6 量子隐形传态原理图3.5 理论与试验研究进展1993年,学术界给出了一种利用量子技术传输信息的实际方案,4年后量子通信技术在奥地利科学家的实验室中正式完成了实验验证。经过十多年的发展,量子通信先后实现了信息传递从600m(2007年)到通信距离144km(2012年)的巨大跨越,标志量子通信从理论阶段走向实用化阶段。下面从量子密钥分配和量子隐形传态两个主要研究领域进行介绍。(1) 量子密钥分配国外:1993年,英国研究小组首先在光纤中,使用相位编码的方法实现了BB84方案,通信传输距离达10km;1995年,该小组将距离提升到30km。瑞士于1993年用偏振光子实现了BB84方案,光子波长1.3mm,传输距离1.1km,误码率0.54%;1995年,将距离提升到23km,误码率为3.4%;2002年,传输距离达到67km。2000年,美国实现自由空间量子密钥分配通信,传输距离达1.6km。2003年,欧洲研究小组实现自由空间中23km的通信。2008年10月,欧盟开通了8个用户的量子密码网络;同月,日本将量子通信速率提高100倍,20km时通信速率达到1.02Mbit/s,100km时通信速率达到10.1kbit/s。目前,国外光纤量子密钥分配的通信距离达300km,量子密钥协商速率最高试验记录在50km光纤传输中超过1Mb/s[2]。图7 北京—天津量子密码实验[1]国内:2004年,郭光灿团队完成了途径北京望京—河北香河—天津宝坻的量子密钥分配,距离125km。2008年,潘建伟团队建成基于商用光纤和诱骗态相位编码的3节点量子通信网络,节点间距离达20km,能实现实时网络通话和3方通话。2009年,郭光灿团队建成世界上第一个“量子政务网”。同年9月,中国科技大学建成世界上第一个5节点全通型量子通信网络,实现实时语音量子密码通信。2011年5月,王建宇团队研发出兼容经典激光通信的“星地量子通信系统”,实现了星地之间同时进行量子通信和经典激光通信。2012年2月17日,合肥市城域量子通信实验示范网建成并进入试运行阶段,具有46个节点,光纤长度1700km,通过6个接入交换和集控站,连接40组“量子电话”用户和16组“量子视频”用户。2013年5月,中科院在国际上首次成功实现星地量子密钥分发的全方位地面试验。同年11月,济南量子保密通信试验网建成,包括三个集控站、50个用户节点[2]。在2016年8月16日,我国发射首颗“墨子号”量子卫星,这标志着我国在全球已构建出首个天地一体化广域量子通信网络雏形,为未来实现覆盖全球的量子保密通信网络迈出了新的一步。(2) 量子隐形传态1997 年,奥地利Zeilinger小组首次成功实现了量子隐形传态通信; 1998 年初,意大利Rome 小组实现将量子态从纠缠光子对中的一个光子传递到另一个光子上的方案; 同年底,美国CIT 团队实现了连续变量(连续相干光场) 的量子隐形传态,美国学者用核磁共振( NMR) 的方法,实现了核自旋量子态的隐形传送。2001 年,美国Shih Y H 团队在脉冲参量下转换中,利用非线性方法实施Bell 基的测量,完成量子隐形传态。2002年,澳大利亚学者将信息编码的激光束进行了“远距传物”。1997 年,我国潘建伟和荷兰学者波密斯特等人合作,首次实现了未知量子态的远程传输;2004 年,潘建伟小组在国际上首次实现五光子纠缠和终端开放的量子态隐形传输,此后又首次实现6光子、8光子纠缠态; 2011 年,在国际上首次成功实现了百公里量级的自由空间量子隐形传态和纠缠分发,解决了通讯卫星的远距离信息传输问题。2012年9月,奥地利、加拿大、德国和挪威研究人员,实现了长达143公里的“隐形传输”[2]。3.6 产业化进展与面临的挑战量子通信的战略意义吸引了西方各国科研机构的关注,IBM、NIST、Battelle、NTT、东芝、西门子等著名公司和机构一直密切关注其发展并投资相关研究。英国政府在2013年发布了为期5年的量子信息技术专项,投入2.7亿英镑用于量子通信和量子计算等方面的研究成果转化,促进新应用和新产业的形成。国外成立了多个专门从事量子通信技术成果转化和商业推广的实体公司。例如美国的MagiQ公司和瑞士日内瓦大学成立的idQuantique公司等,能够提供QKD量子通信的商用化器件、系统和解决方案。法国电信研究院成立的SeQureNet公司从事连续变量量子密钥分发产品的开发。美国洛斯阿拉莫斯国家实验室成立了Qubittek公司,主攻智能电网安全通信领域[4]。国内开展量子通信相关研究的代表性机构包括中国科学技术大学、中国科学院微系统所和技术物理所、清华大学、山西大学和南京大学等。以中国科学技术大学相关研究团队为核心发起成立了科大国盾量子、安徽问天量子和山东量子等产业化实体,进行量子通信前沿研究成果向应用技术和用化产品的转化,国家对量子通信领域持续的专项投入和政策扶持为其发展提供了强劲动力。(a) 量子密钥分发机 (b) 量子安全加密手机图 8 科大国盾量子公司的产品相比其他量子信息技术,QKD无论在理论中、试验中还是实际应用中,都已经取得了一些重要的进展。然而,大规模的应用和推广仍然面临一系列的困难和挑战[4],主要表现以下四个方面:(1) 初期市场规模和用户群体十分有限。量子通信目前主要面向的是有高安全性要求的特定应用场景,如银行、政务和国防等通信网络环境。传统通信业界对于量子通信的应用目前仍然持观望态度,参与度和热情较低。(2) 产业化供应链的建立尚需时日。QKD 系统采用的单光子源和光子探测器等核心器件与传统光学器件完全不同,生产将面临量子设备特有的器件参数、制造工艺等新的挑战,因此需要一段时间的发展与适应。(3) 行业标准与规范研尚不完善。对于任何高新技术而言,测试认证和标准化是商用化推广的必备条件,而新型测试认证技术的开发通常是非常复杂、昂贵和耗时的。目前测评技术和标准化研究已经成为量子通信实用化的一大瓶颈。(4) 基础设施建立目前难以实现。QKD 系统前期需要更多的投入与改造,将原有传统的通信系统升级量子通信系统,将消耗巨额的经济成本。QKD 系统的量子态信号和传统强光信号的混传,所以大规模量子通信组网需要额外的光纤资源进行支持,将对量子通信系统的应用造成限制。此外,量子通信无法共享传统光通信设备等基础设备,需要进行全新部署, 造成前期大量软硬件升级改造的高投入要求。4 量子计算量子计算利用量子态的叠加性和纠缠性信息的运算和处理,其最显著优势在于“操作的并行性”,即个叠加态的量子信息进行一次变换,相当于对个量子信息同时进行操作。在本章中,我们将首先介绍三种典型的量子算法的原理,进而介绍量子机器学习与深度学习算法相关知识,最后介绍量子计算机的基本原理和量子编码相关知识。4.1 典型量子算法量子算法是量子计算的灵魂。可以说,没有量子算法就无法实现量子计算的并行性。因此,寻找和设计量子算法是量子计算的关键。在量子算法的研究中,出现了三个里程碑式的重要算法:Shor算法,Grove算法和HHL算法,它们都具有较高的理论意义和应用价值。(1) Shor算法1994年,应用数学家Shor 提出了一个实用的量子算法,通常称为Shor算法[12]。它的出现使得大整数分解问题在量子计算机中在多项式时间内解决成为可能,它计算复杂度仅为 。显然,相比经典算法,Shor算法相当于进行了指数加速。算法主要思想是将整数质因子分解问题转化为求解量子傅里叶变换的周期,将多个输入制备为量子态叠加,进行并行处理和操作,从而到到了量子加速的目的。在实际应用中, 2001年,IBM公司的研究小组首次在开发的核磁共振(Nuclear magnetic resonance,NMR)量子计算机中使用Shor算法,成功将15分解成3×5,这一成果引起业界广泛的关注和讨论。理论上,一旦更多量子比特的量子计算机研究成功,对于1000位大整数,采用 Shor算法可以在不到1秒内即可进行素因子分解,而采用传统计算机分解需要年(而宇宙的年龄为年)。由此可见在量子计算机面前,现有的公开密钥 RSA体系不再安全。(2) Grove算法搜索问题指的是从个未分类的元素中寻找出某个特定的元素。对于该问题,经典算法逐个地进行搜寻,直到找到满足的元素为止,平均需要,时间复杂度为。由于很多问题都可以看作一个搜索问题,如寻找对称密码(DES/AES等)的正确密钥,搜索方程的最佳参数等,因此Grover算法的用途十分广泛。(3) HHL算法由于机器学习算法中的某些求参过程同样可看作是该类问题,因此学者们已经将 HHL 算法应用到机器学习领域,比如 K-means 聚类,支持向量机,数据拟合等算法中,从而达到加速的目的。4.2 量子机器学习与深度学习算法在量子算法中,有一类算法是应用在机器学习或深度学习领域。由于近年来人工智能和机器学习/深度学习的研究热潮,同样带动了量子机器学习/深度学习的发展和研究。众所周知,传统的机器学习/深度学习算法仍然面临计算瓶颈的挑战。然而,若充分利用量子计算的并行性,则可以进一步优化传统机器学习算法的效率,突破计算瓶颈,加速人工智能进程。量子机器学习的研究可追溯到1995年,Kak最先提出量子神经计算的概念[15]。相继学者们提出了量子聚类、量子深度学习和量子向量机等算法。2015年,潘建伟教授团队在小型光量子计算机上,首次实现了量子机器学习算法[16]。从经典—量子的二元概念出发可以将机器学习问题按照数据和算法类型的不同分为4类,如表1所示[9]。表1 机器学习分类量子机器学习的训练数据必须以某种可以为量子计算机识别的格式载入(即制备量子叠加态),经过量子机器学习算法处理以后形成输出,而此时的输出结果是量子叠加态的,需要经过测量得到最终结果[9],该流程如图9所示。图9量子机器学习的基本流程表2概述了目前文献中见到的一些典型量子机器学习算法,及其所需资源和性能改善特征[9]。表2 主要量子机器学习算法如前所述,量子机器学习算法相比经典算法,有以下显著优势:(1) 量子加速。由于量子态的可叠加性,相比传统计算机,量子算法可以在不增加硬件的基础上实现并行计算,在此基础上利用Shor算法、HHL算法和Grover搜索等算法,可实现相对于完成同样功能的经典算法的二次甚至指数加速[4]。(2) 节省内存空间。将经典数据通过制备量子态叠加编码为量子数据,并利用量子并行性进行存储,可实现指数级地节省存储硬件需求。4.3 量子计算机所谓量子计算机,它是指具有量子计算能力的物理设备。为什么要出现这种设备呢?主要有两个原因:(1) 外部原因:摩尔定律失效。根据摩尔定律,集成电路上可容纳的晶体管数目每隔24个月增加一倍,性能也相应增加一倍。然而,一方面随着芯片元件集成度的提高会导致单位体积内散热增加,由于材料散热速度有限,就会出现计算速度上限,产生“热耗效应”。另一方面元件尺寸的不断缩小,在纳米甚至埃尺度下经典世界的物理规律不再适用,出现“尺寸效应”。(2) 内部原因:量子计算机的强并行性。这是量子计算机相比传统计算机的显著优势,量子计算机和量子算法相互结合,可以将计算效率进行二倍加速甚至指数加速,例如传统计算机计算需要1年的任务,使用量子计算机可能需要不足1秒的时间。不同于传统计算机,量子计算机用来存储数据的对象是量子比特;不同于传统计算机,量子计算机用使用量子逻辑门进行信息操作,如对单个量子操作的逻辑门:泡利-X门,泡利-Y门,泡利-Z门和Hadamard门等;对两个量子操作的双量子逻辑门:受控非门CNOT,受控互换门SWAP等等。这些量子的逻辑门的操作可以看做一种矩阵变换,即乘以幺正矩阵(可看做正交矩阵从实数域推广到复数域)的过程。图10以Hadamard门为例,表述了对量子态的形象操作过程。图 10 量子门的操作示意图由图可知,Hadamard门可以将一个量子态变成两个量子态的叠加状态。形象地说,猫生的状态通过Hadamard门转换成生和死的叠加态(概率为状态幅度的平方,概率各为50%)。这种性质十分有用,是实现并行计算基础,可以将N个输入数据转换成一个叠加的量子态,一次量子计算操作,相当于进行了N个数据操作,即实现了N次的并行,后文提到的量子算法正是利用这些量子逻辑门的变换特性。其他量子逻辑门的幺正矩阵有所不同,但操作也类似,这里不做赘述。此外,量子计算机用使用的量子逻辑门是可逆的;而传统计算机的逻辑门一般是不可逆的。前者操作后产生的能量耗散,而后者进行幺正矩阵变换可实现可逆计算,它几乎不会产生额外的热量,从而解决能耗上的问题。与传统的计算机相同的是,量子计算机的理论模型仍然是图灵机。不同的是,量子计算目前并没有操作系统,代替用量子算法进行控制,这决定了目前的量子计算机并不是通用的计算机,而属于某种量子算法的专用计算机。量子计算机和传统计算机的比较结果如表3所示。表3 量子计算机VS 传统计算机量子计算机的基本原理如图11所示。它主要的过程如下:(1) 选择合适的量子算法,将待解决问题编程为适应量子计算的问题。(2) 将输入的经典数据制备为量子叠加态。(3) 在量子计算机中,通过量子算法的操作步骤,将输入的量子态进行多次幺正操作,最终得到量子末态。(4) 对量子末态进行特殊的测量,得到经典的输出结果。图 11 量子计算机工作原理流程图[20]迄今为止,科学家用来尝试实现量子计算机的硬件系统有许多种,包括液态核磁共振、离子阱、线性光学、超导、半导体量子点等。其中,超导和半导体量子点由于可集乘度高,容错性好等优点,目前被认为是实现量子计算机的两种可能方案[1]。最近,IBM宣布的研制50比特和谷歌研制的72比特量子计算机都是基于低温超导系统的方案。4.4 量子编码理论上,需要极少的量子比特便可在量子计算机中实现复杂的量子计算。然而现实中,一方面量子信道上和量子设备中总存在各种噪声,如量子比特的热量等;另一方面量子的“退相干性”[5]。在量子计算,需要使得所有的量子位都持续处于一种“相干态”,然而在现实中很难做到,目前“相干态”仅能维持几百毫秒,随着量子比特的数量以及与环境相互作用的可能性增加,这个挑战将变得越来越大。这两个因素都能导致量子比特的状态翻转或随机化,导致从而导致量子计算失败。量子编码的目的正是为了纠正或防止这些量子比特发生的错误。虽然量子编码和经典编码的基本想法类似,即要以合适的方式引进信息冗余,以提高信息的抗干扰能力,但量子码可不是经典码的简单推广。在在量子情况下,编码存在着一些基本困难,表现在如下3方面[7]:(1) 经典编码中,为引入信息冗余,需要将一个比特复制多个比特。但在量子力学中,量子态不可克隆。(2) 经典编码在纠错时,需要进行测量,以确定错误图样。在量子情况下,测量会引起态坍缩,从而破坏量子相干性。(3) 经典码中的错误只有一种,即0,1之间的跃迁。而量子错误的自由度要大得多,对于一个确定的输入态,其输出态可以是二维空间中的任意态。量子编码按其原理,可分为量子纠错码、量子防错码、和量子避错码,其中量子纠错码是经典纠错码的量子推广。在各种量子纠错方案,实际上都假设了发生错误的量子比特数是给定的,例如常见的有纠一位错的量子码。典型的方案是Shor首次给出了一个新颖的纠错编码技术[17],利用9个量子比特来编码一个量子比特信息,可以纠正一位比特错误。5 后量子密码量子计算的快速发展,对当前广泛成熟使用的经典密码算法,特别是公钥密码算法(如RSA和ECC等)产生了极大的威胁和挑战,具体包括[11]:(1) 所有基于整数分解和离散对数上的非对称密码体制都是不安全的。如RSA、EEC公钥密码算法,它们在多项式时间内可以破解。那么当前主流的公钥加密、数字签名算法将不再安全。(2) 分组密码和序列密码的比特安全性将降低为原来密钥长度的1/2。为了抵抗这种攻击,对称加密算法通过增加密钥长度(2倍密钥长度)即可。(3) Hash 算法比特安全性将降低为原来的2/3。为了抵抗量子计算的攻击,人们提出抗量子密码体制,也称为后量子密码体制(Post-Quantum Cryptography),即在量子计算机出现之后仍然安全的密码体制。它主要包含基于 Hash的密码体制、基于编码的密码体制、基于格的密码体制和基于多变量的密码体制。事实上,从上述的影响结果来看,目前量子计算仅对公钥密码影响最大,而对分组密码、序列密码、哈希算法相对影响较小,因此可以看作它们也具有一定的抗量子计算攻击的特性。表4 抗量子密码体制及其具体算法目前,美国和欧洲正在大力对其投入研究,并快速推动其实用化。2015 年8月,美国国家安全局 NSA 宣布将当前美国政府所使用的“密码算法 B 套件”进行安全性升级,用于2015年至抗量子密码算法标准正式发布的空窗期,并最终过渡到抗量子密码算法。2016 年秋到2017年11月,NIST面向全球征集抗量子密码算法,然后进行 3~5年的密码分析工作,预计在 2022年到2023年,完成抗量子密码标准算法起草并发布。6 总结量子信息技术主要包含量子通信和量子计算两个分支,本文分别介绍了这两个分支技术。从理论角度的看,可用数学证明QKD能达到“绝对安全”。然而实践中由于设备和技术的缺陷,QKD不可能达到理想的“绝对安全”,离完全实用化进程还有很长的路需要探索。对此持既批判吹捧量子密码替代传统密码的极端观点,也看好未来量子密码的发展前景。从目前技术成熟度来看,量子密钥分配 ( QKD ) 是最为成熟的量子技术,它结合对称加密技术形成安全的保密通信系统,目前已经实现了商用化,但主要面向政务、国防、金融等安全性要求很高的特定应用场景,离全面推广和实用化还有很长的距离。从工业界研究热度来看,多数IT和互联网公司致力于研究量子计算,提出“量子计算+人工智能”,以解决计算力瓶颈问题。它具有广泛的应用价值,值得持续关注。从影响程度来看,量子计算的发展对以RSA和ECC为代表公钥密码学产生了巨大威胁,但对对称加密算法(如AES)的威胁较少。可预见将来,即使量子计算机被研发出来,传统密码也不会完全被替代,而将出现传统密码与量子密码(QKD)相互促进、共同繁荣的景象。从我国发展状况来看,量子通信技术发展速度迅猛,在理论研究和实验技术上均取得了许多重大突破,成果卓越。然而,量子算法、量子计算机的研究与欧美发达国家相比,仍有很大的差距,相关研究仍需努力。参考文献[1] 郭光灿,张昊,王琴. 量子信息技术发展概况[J]. 南京邮电大学学报(自然科学版), 2017, 37(3):1-14.[2] 徐兵杰,刘文林,毛钧庆,等. 量子通信技术发展现状及面临的问题研究[J]. 通信技术, 2014(5):463-468.[3] 王矿岩. 量子通信技术发展现状及面临的问题研究[J]. 通讯世界, 2017(1):110-111.[4] 赖俊森,吴冰冰,汤瑞,等. 量子通信应用现状及发展分析[J]. 电信科学, 2016, 32(3):123-129.[5] Bennett C H, Brassard G. Quantum cryptography: Public key distribution and coin tossing[J]. Theoretical Computer Science, 2014, 560:7-11.[6] 陈锦俊, 吴令安, 范桁. 量子保密通讯及经典密码[J]. 物理, 2017, 46(3):137-144.[7] 段路明, 郭光灿. 量子信息讲座 第三讲 量子编码[J]. 物理, 1998(8):496-499.[8] 韩永建. 量子计算原理及研究进展[J]. 科技导报, 2017, 35(23):70-75.[9] 陆思聪, 郑昱, 王晓霆,等. 量子机器学习[J]. 控制理论与应用, 2017(11).[10] 黄一鸣, 雷航, 李晓瑜. 量子机器学习算法综述[J]. 计算机学报, 2018(1).[11] 刘文瑞. 抗量子计算攻击密码体制发展分析[J]. 通信技术, 2017, 50(5): 1054-1059.[12] Shor P W. Algorithms for quantum computation: Discrete logarithms and factoring [C]// Proceedings of the 35th Annual IEEE Symposium on the Foundations of Computer Science. Piscataway, NJ: IEEE, 1994:124-134.[13] Grover L K. A fast quantum mechanical algorithm for database search[C]// Twenty-Eighth ACM Symposium on Theory of Computing. ACM, 1996:212-219.[14] Harrow A W, Hassidim A, Lloyd S. Quantum algorithm for linear systems of equations. Phys Rev Lett, 2009, 103:150502.[15] Kak S. On quantum neural computing[J]. Systems Control & Information, 1995, 52(3-4):143-160.[16] Su Z E, Wang X L, Lu C Y, et al. Entanglement-based machine learning on aquantum computer[J]. Physical Review Letters, 2015, 114(11):110504.[17] Shor P W. Scheme for reducing decoherence in quantum computer memory[J]. Physical Review A, 1995, 52(4):R2493.[18] 孙晓明. 量子计算若干前沿问题综述[J]. 中国科学:信息科学, 2016, 46(8):982.[19] 赵红敏. 量子纠错与经典纠错的比较[J]. 河北科技大学学报, 2008, 29(3):211-213.[20] Makarov V. Quantum cryptography and quantum cryptanalysis [D]. 2007.[1] 这里“不可分割”的含义应该这样理解,比如不可能分割出0.5个原子。[2]如图4所示,测量基对应为两种不同的偏振片,每个偏振片有两个正交的方向。当偏振片方向可以通过偏振片时,测量结果正确。当偏振片方向不是偏振片的方向,无法通过偏振片,测量结果错误。[3]由2.3节可知,20个量子比特可同时存储100万个号码。[4] 表示计算复杂度从降为。[5]通俗地讲,两束频率完全相同的光源产生相干的量子,它们是相互关联的,即对一个量子进行处理,影响就会立即传送到另一个量子,它们是量子并行处理的基础。但由于外部环境的原因,量子由“相干态”退化为“非相干态”,操作一个量子不会影响另一个量子,它们之间是独立的(类似经典计算机的比特),这就是所谓的“退相干性”。来自微信